L'intelligence artificielle est en pleine révolution discrète. Alors que nous sommes encore émerveillés par la façon dont ChatGPT fournit des réponses mot par mot, un nouveau mode de pensée pour l'IA émerge silencieusement : les modèles à langage à diffusion ressemblent à un sage qui réfléchit plusieurs fois, sans se précipiter pour donner une réponse, mais en y réfléchissant sur plusieurs dimensions temporelles, pour finalement produire des résultats plus précis.

Ce nouveau modèle, appelé dLLM, remet entièrement en question le mode de fonctionnement traditionnel de l'IA, qui générait les mots un par un. Il utilise une stratégie d'élimination itérative du bruit, comme un peintre qui retravaille les détails sur une toile, et chaque itération s'approche davantage de la bonne réponse. Cette capacité à générer en parallèle a permis une amélioration qualitative de la génération de texte.

Note de la source de l'image : l'image a été générée par l'IA, fournie par le service de licence Midjourney

Cependant, les chercheurs en intelligence artificielle ont découvert un phénomène énigmatique : ces modèles apparemment intelligents commettent souvent une erreur fatale — ils se concentrent uniquement sur la réponse finale, ignorant complètement les précieux indices obtenus pendant le processus de réflexion. Cela ressemble à un étudiant qui écrit la bonne réponse sur sa copie, mais qui la change à la dernière minute en une mauvaise réponse.

Une équipe de recherche conjointe de l'Université Zhejiang et de Ant Group a rapidement identifié l'essence de ce problème. À travers de nombreuses expériences, ils ont constaté que les dLLM montrent fréquemment un phénomène étrange lors de leur raisonnement : le modèle arrive à une bonne réponse à un certain stade intermédiaire, mais ensuite se rétracte lui-même dans les itérations suivantes, aboutissant finalement à une conclusion erronée.

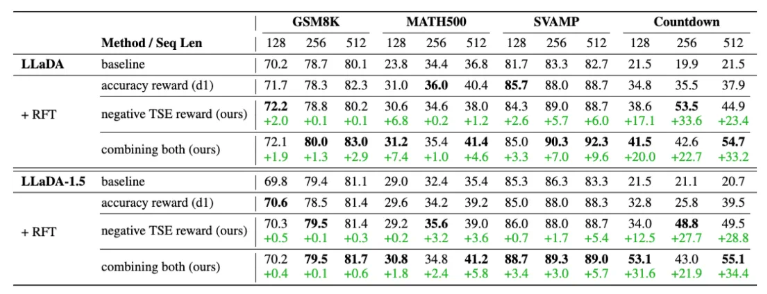

Face à ce défi, l'équipe de recherche a proposé deux solutions créatives. La première, appelée TCV (vote de cohérence temporelle), ressemble à un vote démocratique pour chaque instant de réflexion de l'IA. Contrairement à la méthode traditionnelle, qui nécessite de générer à plusieurs reprises la réponse complète de manière maladroite, le TCV utilise habilement les résultats intermédiaires déjà existants, permettant à chaque étape temporelle de participer, et en sélectionnant ainsi la meilleure réponse grâce à l'intelligence collective. L'avantage de cette méthode est qu'elle n'ajoute presque aucun coût de calcul, tout en améliorant significativement la précision.

La deuxième innovation est la méthode TCR (renforcement de la cohérence temporelle), qui introduit un nouveau concept : l'entropie sémantique temporelle. Ce terme apparemment académique décrit en réalité le degré de stabilité de la pensée de l'IA. Les recherches ont montré que les modèles qui maintiennent une forte cohérence pendant la génération produisent généralement des résultats plus fiables. Le TCR agit comme un stabilisateur interne pour l'IA, lui permettant de garder une meilleure cohérence logique pendant sa réflexion.

Les résultats expérimentaux sont encourageants. Dans plusieurs tâches de raisonnement mathématique et logique populaires, ces deux méthodes ont démontré une amélioration remarquable des performances. Plus important encore, les modèles entraînés ne sont pas seulement plus précis, mais aussi plus stables et plus simples — cela signifie que l'IA peut non seulement fournir la bonne réponse, mais aussi atteindre l'objectif de manière plus élégante.

La portée de cette recherche dépasse largement les avancées techniques. Elle offre à tout le domaine de l'intelligence artificielle un nouvel angle de réflexion : peut-être ne devrions-nous pas nous concentrer uniquement sur la sortie finale de l'IA, mais plutôt sur l'ensemble du processus de réflexion. Comme la pensée créative humaine, parfois les éclairs d'idées se cachent dans les étapes intermédiaires de la pensée.

Les résultats actuels ne constituent qu'un début. Avec l'amélioration continue de cette stratégie d'optimisation selon la dimension temporelle, nous avons toutes les raisons de croire que l'IA du futur sera plus intelligente et plus fiable. Ils ne seront plus des machines froides fournissant des réponses, mais des partenaires intelligents capables de penser, de réfléchir et d'apprendre à partir des erreurs. Cette révolution concernant la manière de penser de l'IA apporte une vitalité et des possibilités sans précédent au domaine de la génération de texte intelligent.

Adresse du papier : https://arxiv.org/abs/2508.09138

Page principale du projet : https://aim-uofa.github.io/dLLM-MidTruth/