Récemment, Apple a dévoilé discrètement deux modèles de vision et langage (VLM) de premier plan - FastVLM et MobileCLIP2 - sur la plateforme Hugging Face, suscitant une grande attention dans le domaine de l'intelligence artificielle. Ces deux modèles, grâce à leur optimisation exceptionnelle des performances et à leur capacité d'exécution efficace en local, ouvrent de nouvelles possibilités pour les applications AI sur les appareils de bord. L'équipe d'édition d'AIbase a analysé en profondeur les points forts techniques et les scénarios d'application potentiels de ces deux modèles, offrant aux lecteurs une interprétation récente.

FastVLM : une révolution visuelle-langagière sur iPhone avec une vitesse 85 fois plus rapide

FastVLM est un modèle de vision et langage optimisé pour le traitement d'images haute résolution, développé sur le framework MLX propre à Apple, conçu spécifiquement pour les appareils Apple Silicon. En comparaison avec les modèles similaires, FastVLM réalise un saut qualitatif en termes de vitesse et d'efficacité. Selon les données officielles, le temps de réponse au premier mot (TTFT) s'est amélioré de 85 fois, le volume du encodeur visuel a été réduit de 3,4 fois, et même avec une taille de paramètres de 0,5 B, il peut rivaliser en performance avec des modèles comme LLaVA-OneVision.

Le cœur de FastVLM réside dans son encodeur visuel hybride FastViT-HD innovant, qui fusionne les couches de convolution et les modules Transformer, tout en combinant des techniques de poolage multi-échelles et de sous-échantillonnage, réduisant ainsi considérablement le nombre de tokens visuels nécessaires pour traiter des images haute résolution - 16 fois moins que les ViT traditionnels, et 4 fois moins que les FastViT. Cette optimisation extrême améliore non seulement la vitesse de raisonnement, mais réduit également significativement la consommation de ressources informatiques, ce qui en fait un modèle particulièrement adapté aux appareils mobiles tels qu'iPhone.

En outre, FastVLM prend en charge un traitement entièrement local, sans dépendre du téléchargement de données vers le cloud, correspondant parfaitement à la philosophie de protection de la vie privée d'Apple. Cela lui offre d'importantes perspectives d'application dans des scénarios sensibles, tels que l'analyse d'images médicales. AIbase considère que le lancement de FastVLM marque un autre grand progrès d'Apple dans le domaine de l'IA côté terminal.

MobileCLIP2 : modèle CLIP léger, permettant des interactions multimodales en temps réel

MobileCLIP2, publié en parallèle avec FastVLM, est un modèle léger basé sur l'architecture CLIP, axé sur une alignement efficace des caractéristiques entre images et textes. MobileCLIP2 hérite de la capacité d'apprentissage zéro-échantillon de CLIP, mais améliore encore l'efficacité computationnelle, ce qui en fait un modèle idéal pour les appareils limités en ressources.

Ce modèle réduit significativement le délai de raisonnement grâce à une conception d'architecture simplifiée et à un processus d'entraînement optimisé, tout en maintenant une forte capacité d'alignement image-texte. En combinaison avec FastVLM, MobileCLIP2 fournit un soutien puissant pour les tâches multimodales en temps réel, telles que la recherche d'images, la génération de contenus et les interactions avec des assistants intelligents.

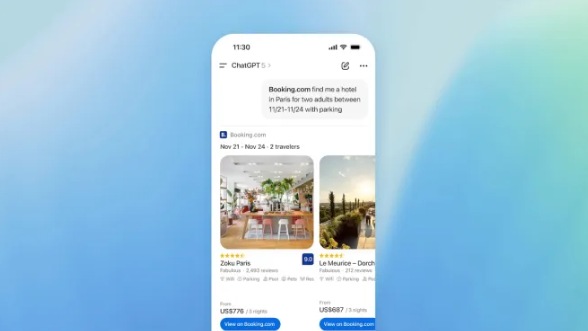

Description en temps réel des images vidéo : une nouvelle expérience d'IA dans le navigateur

L'un des points forts du dépôt de FastVLM et MobileCLIP2 par Apple est leur performance révolutionnaire dans la description en temps réel des images vidéo. Les démonstrations officielles montrent que ces deux modèles peuvent analyser et générer des descriptions de contenu vidéo presque en temps réel dans un environnement de navigateur (avec prise en charge WebGPU). Par exemple, lorsqu'un utilisateur télécharge une vidéo, le modèle peut rapidement analyser le contenu de l'image et générer une description textuelle précise, avec une rapidité de réponse impressionnante.

L'équipe d'édition d'AIbase considère que cette fonctionnalité fournit une base technique pour les interactions en temps réel sur des appareils tels que les lunettes AR et les assistants intelligents. Que ce soit pour traduire immédiatement le texte contenu dans une vidéo, ou fournir une description de scène aux personnes malvoyantes, FastVLM et MobileCLIP2 montrent un grand potentiel.

Agent automatique et collecte de données opérationnelles : les ambitions d'Apple en matière d'IA

Les experts estiment que le dépôt de FastVLM et MobileCLIP2 n'est pas seulement une percée technologique, mais aussi une étape importante pour l'architecture future de l'écosystème IA d'Apple. La haute efficacité et la capacité d'exécution locale de ces deux modèles offrent un soutien idéal pour la construction d'agents automatisés. Ces agents peuvent exécuter des tâches de manière autonome sur l'appareil, comme l'analyse du contenu de l'écran, la documentation des opérations utilisateur et la collecte de données.

Avec l'implémentation de modèles légers sur des appareils tels qu'iPhone et iPad, Apple espère encore améliorer davantage son écosystème d'IA côté terminal, réduire sa dépendance aux calculs en cloud et renforcer la sécurité des données utilisateur. Cette stratégie correspond étroitement à l'idée d'Apple d'une intégration approfondie du matériel et du logiciel, annonçant ses ambitions plus importantes dans les domaines des dispositifs portables intelligents et de l'IA au bord.

Écosystème open source et soutien aux développeurs

Le code et les poids des modèles FastVLM et MobileCLIP2 sont désormais pleinement disponibles en open source, hébergés sur la plateforme Hugging Face (FastVLM : https://huggingface.co/collections/apple/fastvlm-68ac97b9cd5cacefdd04872e), et comprennent une application de démonstration iOS/macOS basée sur le framework MLX. Apple a également publié un article technique détaillé (https://www.arxiv.org/abs/2412.13303), offrant aux développeurs une référence technique approfondie.

AIbase considère que le dépôt d'Apple non seulement propulse la popularité des modèles de vision-langage, mais fournit également aux développeurs un cadre de modèle efficace, facilitant la création d'applications IA plus intelligentes et plus rapides. Qu'il s'agisse de développeurs individuels ou de sociétés, tous peuvent construire rapidement des applications innovantes adaptées aux appareils de bord grâce à ces ressources open source.

La vision future d'Apple en matière d'IA

Le lancement de FastVLM et MobileCLIP2 illustre l'approfondissement des compétences techniques et la mise en place prospective d'Apple dans le domaine des modèles de vision-langage. Ces deux modèles, grâce à leur optimisation extrême des performances et à leur capacité d'exécution locale puissante, apportent une amélioration révolutionnaire à l'expérience d'interaction IA sur les appareils mobiles. Du traitement en temps réel des vidéos aux applications potentielles des agents automatisés, Apple agit concrètement pour redéfinir l'avenir de l'IA.