हाल ही में एप्पल के अनुसंधान टीम ने एक नई सिखाने की विधि, "चेक सूची प्रतिक्रिया से प्रबलन अधिग्रहण" (RLCF) के बारे में अपने नए पेपर में शोध किया है, जिसके माध्यम से विशिष्ट कार्य सूची के साथ पारंपरिक मानव लाइक या डिसलाइक अंकन प्रणाली के स्थान पर, बड़े भाषा मॉडल के जटिल निर्देशों के कार्यान्वयन में बहुत बढ़ोतरी हुई है।

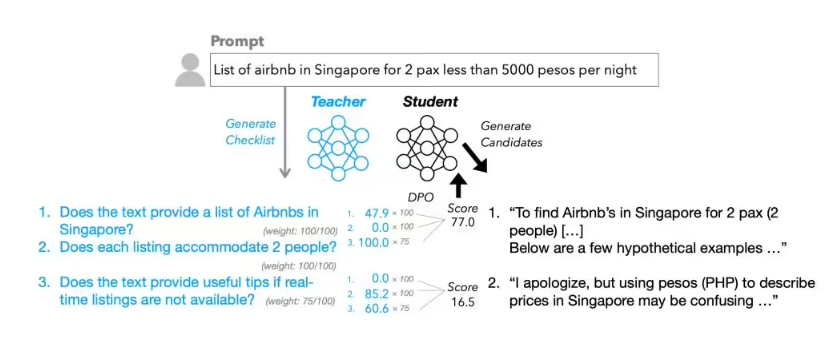

जानकारी के अनुसार, RLCF का पूरा नाम "चेक सूची प्रतिक्रिया से प्रबलन अधिग्रहण" है, जो वर्तमान में व्यापक रूप से उपयोग किए जाने वाले "मानव प्रतिक्रिया से प्रबलन अधिग्रहण" (RLHF) विधि से बहुत अलग है। पारंपरिक RLHF विधि मुख्य रूप से मानव द्वारा सरल लाइक या डिसलाइक मूल्यांकन पर निर्भर करती है, जबकि RLCF प्रत्येक उपयोगकर्ता निर्देश के लिए विस्तृत चेक सूची बनाता है और विषयों के 0-100 अंक के मानक पर विस्तृत मूल्यांकन करता है, जिसके आधार पर मॉडल के अद्यतन के लिए दिशा निर्देश दिया जाता है।

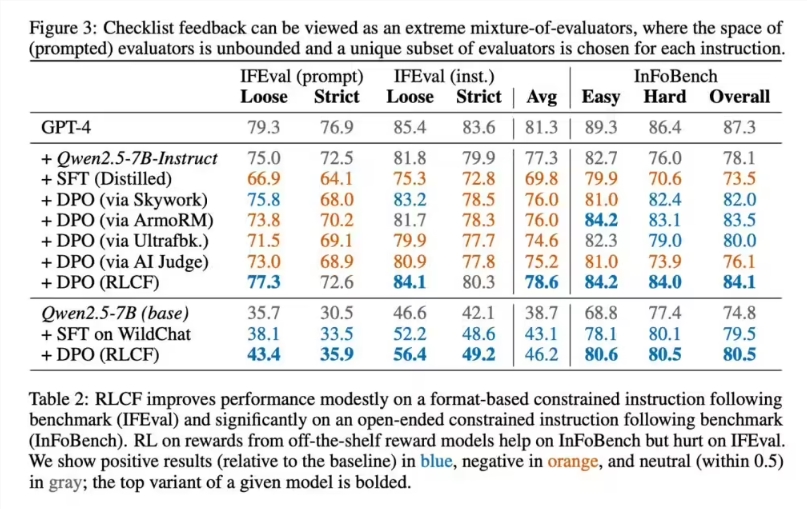

एप्पल अनुसंधान टीम ने शक्तिशाली निर्देश अनुसरण मॉडल Qwen2.5-7B-Instruct को परीक्षण के लिए चुना और पांच सामान्य मूल्यांकन मानकों पर व्यापक जांच की। परीक्षण परिणामों से पता चला कि RLCF विधि सभी परीक्षण में सुधार करने वाली एकमात्र शिक्षा विधि है।

विस्तृत डेटा बताता है कि FollowBench पर, कठोर संतुष्टि दर में 4 प्रतिशत की वृद्धि हुई। InFoBench अंकन में 6 अंक की वृद्धि हुई, Arena-Hard जीत के अंक में 3 अंक की वृद्धि हुई। कुछ विशिष्ट कार्यों में, कार्यक्षमता में अधिकतम 8.2% की वृद्धि हुई। ये आंकड़े दर्शाते हैं कि चेक सूची प्रतिक्रिया विधि के जटिल बहु-चरण कार्यों के साथ निपटने में विशेष रूप से उत्कृष्ट प्रदर्शन करती है।

तकनीकी कार्यान्वयन के मामले में, एप्पल टीम के चेक सूची बनाने की प्रक्रिया अत्यधिक नवाचार है। उन्होंने बड़े पैमाने पर Qwen2.5-72B-Instruct मॉडल का उपयोग किया, मौजूदा अनुसंधान विधियों के साथ जोड़कर, 13 लाख निर्देशों के लिए "WildChecklists" नामक विशेष डेटा सेट बनाया। चेक सूची में स्पष्ट द्विआधारी निर्णय शामिल हैं, जैसे कि "क्या स्पैनिश में अनुवाद किया गया?" आदि विशिष्ट मांगें। बाद में, बड़ा मॉडल उम्मीदवार उत्तरों के लिए प्रत्येक विवरण के लिए अंक देता है, जिसके बाद एक संयुक्त भारित प्रक्रिया के माध्यम से शिक्षा पुरस्कार संकेत बनाया जाता है, जो छोटे मॉडल के अधिग्रहण प्रक्रिया के लिए दिशा निर्देश देता है।

हालाँकि, एप्पल अनुसंधानकर्ता इस विधि की सीमाओं की ईमानदारी से घोषणा करते हैं। पहले, RLCF के लिए अधिक शक्तिशाली मॉडल के आधार पर निर्णय लेने की आवश्यकता होती है, जो गणना संसाधन सीमित परिस्थितियों में लागू करने में कठिनाई हो सकती है। दूसरे, यह विधि जटिल निर्देश के कार्यान्वयन के सुधार के लिए डिज़ाइन की गई है और सुरक्षा अनुरूपता के उद्देश्य के लिए नहीं है, इसलिए वर्तमान सुरक्षा मूल्यांकन और अनुकूलन योजनाओं के स्थानापन्न नहीं हो सकती है। अन्य प्रकार के AI कार्यों के लिए, RLCF विधि के उपयोग की लाभकारिता के लिए आगे के प्रयोग आवश्यक हैं।

उद्योग के विशेषज्ञ मानते हैं कि एप्पल द्वारा प्रस्तावित RLCF विधि AI मॉडल शिक्षा के लिए नई दृष्टि प्रदान करती है, विशेष रूप से जटिल बहु-चरण कार्यों के साथ निपटने में उल्लेखनीय लाभ है। तकनीक के आगे विकास के साथ, यह विधि वास्तविक अनुप्रयोगों में अधिक भूमिका निभाने में सक्षम हो सकती है।