Recentemente, a DeepSeek lançou uma nova atualização do modelo de IA de推理 R1, que demonstrou um desempenho excepcional em várias avaliações matemáticas e de programação. No entanto, a DeepSeek não revelou as fontes de dados usadas no treinamento de seu modelo, levantando dúvidas entre alguns pesquisadores de IA que especulam que o modelo pode ter sido parcialmente treinado com base na série de modelos Gemini da Google.

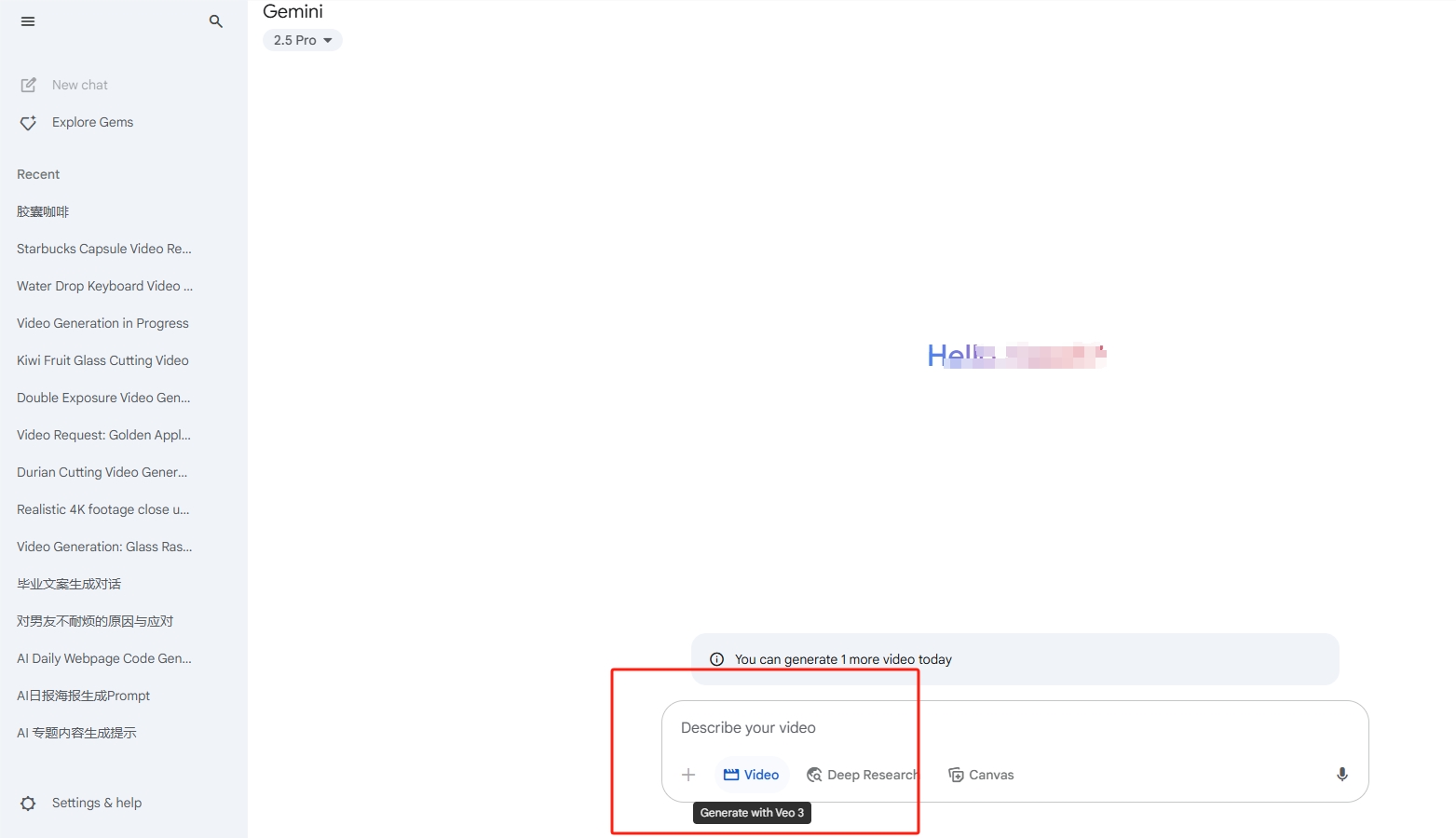

O desenvolvedor de Melbourne, Sam Paeach, afirmou que encontrou muitas semelhanças no uso de palavras e expressões entre o modelo R1-0528 da DeepSeek e o Gemini2.5Pro da Google. Embora isso não seja uma evidência direta, outro desenvolvedor — o fundador anônimo do projeto SpeechMap — também mencionou que os "traços de pensamento" gerados pelo modelo da DeepSeek durante o processo de推理 são praticamente idênticos aos da Gemini. Essa descoberta reacendeu os debates sobre se a DeepSeek utilizou dados de concorrentes durante o treinamento.

Fonte da imagem: Imagem gerada por IA, licenciada pelo provedor Midjourney

Ao longo do mês de dezembro passado, a DeepSeek já havia sido criticada por frequentemente identificar-se como o ChatGPT da OpenAI em seu modelo V3, sugerindo que talvez tenha sido treinado com registros de conversas do ChatGPT. Mais cedo este ano, a OpenAI informou à imprensa que havia encontrado evidências relacionadas à técnica conhecida como "data distillation", que é um método de treinamento de novos modelos a partir de informações extraídas de grandes modelos. A Bloomberg relatou que, no final de 2024, a Microsoft, parceira da OpenAI, descobriu que grande parte dos dados foi roubada através de contas de desenvolvedores da OpenAI que podem estar ligadas à DeepSeek.

Embora a técnica de "refino" não seja incomum na comunidade de IA, a OpenAI especificamente proibiu o uso de seus modelos para criar produtos concorrentes. É importante notar que, devido ao grande volume de conteúdo de baixa qualidade na web aberta, muitos modelos de IA tendem a imitar erroneamente as palavras e frases uns dos outros durante o treinamento. Isso torna ainda mais complexa a análise das fontes de dados de treinamento.

O especialista em inteligência artificial Nathan Lambert acredita que não seria impossível que a DeepSeek tenha usado os dados da Gemini da Google durante o treinamento. Ele menciona que a DeepSeek tem recursos financeiros suficientes para aproveitar os melhores modelos via API e gerar dados sintéticos. Para evitar que dados sejam refinados, as empresas de IA estão constantemente fortalecendo suas medidas de segurança. Por exemplo, a OpenAI começou a exigir verificação de identidade para organizações acessarem certos modelos avançados, enquanto a Google está aumentando a segurança de sua plataforma AI Studio, limitando o acesso às trajetórias geradas pelos modelos.

DeepSeek pode ter usado os dados do Google Gemini para treinar o novo modelo de IA

AIbase基地

Este artigo é do AIbase Daily

Bem-vindo à coluna [AI Daily]! Este é o seu guia para explorar o mundo da inteligência artificial todos os dias. Todos os dias apresentamos os destaques da área de IA, com foco nos desenvolvedores, para o ajudar a obter insights sobre as tendências tecnológicas e a compreender as aplicações inovadoras de produtos de IA.