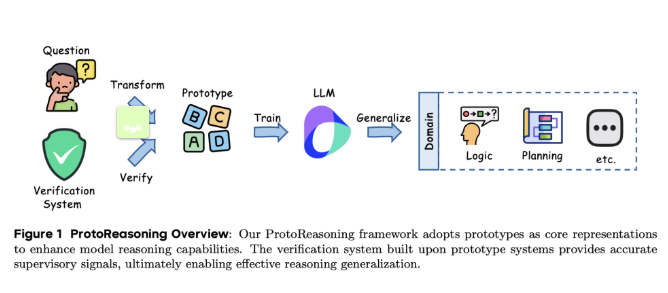

Récemment, l'équipe de recherche de ByteDance et de l'Université de Shanghai Jiao Tong a lancé un nouveau cadre appelé ProtoReasoning, visant à renforcer la capacité de raisonnement des grands modèles linguistiques (LLMs) en utilisant des prototypes logiques. Ce cadre utilise des représentations de prototypes structurés, tels que Prolog et PDDL, pour avancer le raisonnement transversal.

Au cours des dernières années, les grands modèles linguistiques ont connu des progrès notables dans le raisonnement transversal, notamment grâce à l'application de la technologie du raisonnement à longue chaîne. Les recherches ont montré que ces modèles présentent d'excellentes capacités dans des tâches telles que les mathématiques et la programmation, ainsi qu'une excellente performance dans des domaines non liés comme les problèmes logiques et l'écriture créative. Cependant, la raison de cette flexibilité n'est pas encore complètement claire. Une explication possible est que ces modèles ont appris des modèles de raisonnement fondamentaux, c'est-à-dire des prototypes de raisonnement abstraits transversaux, qui peuvent aider le modèle à mieux gérer différents types de problèmes.

Le cadre ProtoReasoning améliore la capacité de raisonnement du modèle en utilisant des représentations de prototypes structurés, comprenant deux modules principaux : le constructeur de prototypes et le système de vérification. Le constructeur de prototypes convertit les questions en langage naturel en représentations formalisées, tandis que le système de vérification vérifie la correction des réponses. Dans l'application de Prolog, les chercheurs ont conçu un pipeline en quatre étapes pour générer divers problèmes logiques et les valider avec SWI-Prolog. Pour les tâches de planification, l'équipe de recherche a utilisé PDDL pour construire des tâches de génération, de réalisation et de réorganisation de plans, et a vérifié leur exactitude avec le validateur VAL.

L'évaluation du cadre ProtoReasoning a utilisé un modèle expert de 150 milliards de paramètres (dont 15 milliards sont actifs), entraîné sur des échantillons de qualité élevée sélectionnés soigneusement en Prolog et en PDDL. Les résultats montrent que le modèle a montré une amélioration significative dans le raisonnement logique, la planification et plusieurs tests standards. En particulier, les expériences comparatives avec la version en langage naturel ont montré que l'entraînement basé sur Prolog présente des performances proches de la version en langage naturel en matière de raisonnement logique, confirmant ainsi l'efficacité de l'entraînement avec des prototypes structurés.

Le cadre ProtoReasoning démontre le rôle important des prototypes de raisonnement abstrait dans la transférabilité des connaissances transversales des grands modèles linguistiques. Bien que les résultats expérimentaux soient encourageants, les propriétés spécifiques des prototypes de raisonnement nécessitent une exploration théorique supplémentaire. Les recherches futures viseront à formaliser mathématiquement ces concepts et à valider les résultats expérimentaux à l'aide de modèles et de jeux de données open source.

Article : https://arxiv.org/abs/2506.15211

Points clés :

🌟 Le cadre ProtoReasoning utilise Prolog et PDDL pour améliorer la capacité de raisonnement logique des grands modèles linguistiques.

🧠 Grâce aux représentations de prototypes structurés, le modèle a connu une amélioration notable dans le raisonnement logique, la planification et les tâches de résolution de problèmes généraux.

🔍 Les recherches futures se concentreront sur l'exploration des fondements théoriques des prototypes de raisonnement et la validation de l'efficacité des résultats expérimentaux.