Le 4 juillet 2025, Kuaizhi Wanwei a poursuivi son initiative en ouvrant le code de la deuxième génération du modèle de récompense Skywork-Reward-V2. Cette série comprend 8 modèles de récompense basés sur différents modèles de base, avec des tailles de paramètres allant de 600 millions à 8 milliards. Dès sa sortie, elle a remporté toutes les évaluations sur sept listes de classement principales de modèles de récompense, devenant ainsi un point central dans le domaine des modèles de récompense open source.

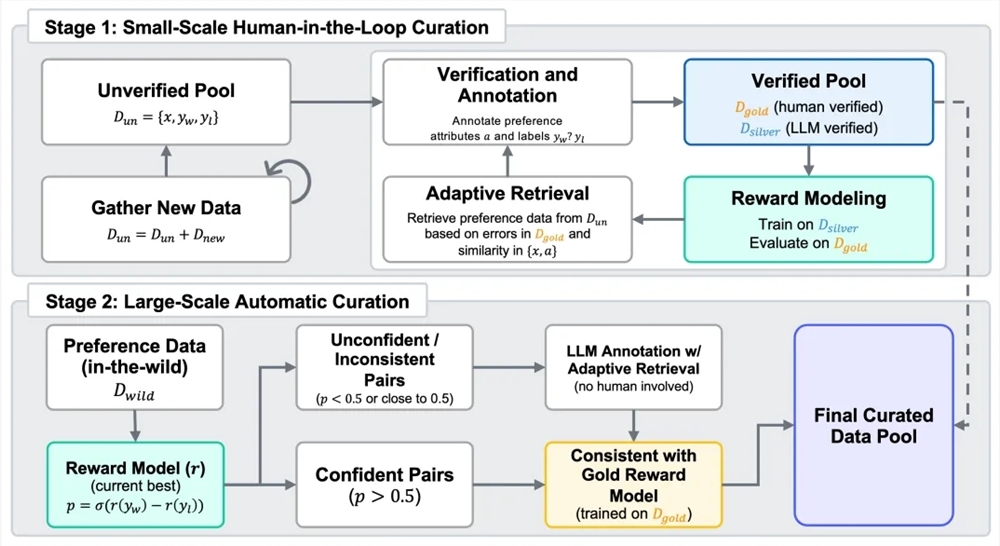

Les modèles de récompense jouent un rôle clé dans le processus d'apprentissage par renforcement à partir des retours humains (RLHF). Pour créer une nouvelle génération de modèles de récompense, Kuaizhi Wanwei a construit un ensemble de données hybrides intitulé Skywork-SynPref-40M, comprenant 40 millions de paires de préférences. En ce qui concerne le traitement des données, l'équipe a adopté un processus en deux étapes combinant l'humain et l'intelligence artificielle. Elle a d'abord construit un pool initial de préférences non vérifiées, puis utilisé des modèles de langage à grande échelle pour générer des attributs auxiliaires. Les annotateurs humains ont ensuite examiné soigneusement certaines données conformément à des protocoles stricts et à l'aide d'outils externes et de modèles de langage, créant ainsi un petit ensemble de données "d'or" de haute qualité. Par la suite, en s'appuyant sur les balises de préférence du "jeu d'or", le groupe a combiné la génération à grande échelle de modèles de langage pour produire des données "d'argent" de haute qualité, optimisant continuellement via plusieurs itérations. La deuxième étape se concentre sur une extension automatique à grande échelle des données, utilisant le modèle de récompense entraîné pour filtrer la cohérence, réduisant ainsi la charge d'annotation humaine tout en maintenant un équilibre entre la quantité et la qualité des données de préférence.

La série Skywork-Reward-V2 développée à partir d'un ensemble de données hybrides de haute qualité démontre une large applicabilité et des capacités exceptionnelles. Elle couvre plusieurs dimensions telles que l'alignement général des préférences humaines, la correction objective, la sécurité, la résistance au biais de style, ainsi que la capacité d'extension Best-of-N. Sur sept benchmarks principaux pour les modèles de récompense, tels que Reward Bench v1/v2, PPE Preference & Correctness, RMB, RM-Bench, JudgeBench, elle atteint tous les niveaux les plus élevés actuels (SOTA). Même le modèle le plus petit, Skywork-Reward-V2-Qwen3-0.6B, affiche des performances presque égales à celles du modèle le plus puissant de la génération précédente. Skywork-Reward-V2-Qwen3-1.7B dépasse même le SOTA des modèles de récompense open source actuels. Le modèle le plus grand, Skywork-Reward-V2-Llama-3.1-8B, dépasse largement tous les benchmarks principaux, devenant ainsi le meilleur modèle de récompense open source en termes de performance globale.

Cette série de modèles possède également une capacité à couvrir diverses préférences humaines. Sur les benchmarks généraux d'évaluation des préférences, elle dépasse plusieurs modèles de plus grande taille ainsi que les derniers modèles de récompense génératifs. Concernant les évaluations de correction objective, elle se distingue particulièrement dans les tâches nécessitant des connaissances. Dans plusieurs évaluations de compétences avancées, y compris les tâches Best-of-N, les tests de résistance aux biais, la compréhension d'instructions complexes et la véracité des jugements, elle obtient des résultats dominants, démontrant ainsi une excellente capacité de généralisation et d'utilité pratique.

De plus, le processus de sélection des données présente une grande extensibilité, ce qui améliore significativement les performances des modèles de récompense. Les données de préférence triées et filtrées efficacement peuvent continuer à améliorer les performances globales du modèle lors de plusieurs itérations d'entraînement, surtout dans la phase automatique à grande échelle de l'étape deux. Les expériences des versions antérieures montrent qu'en utilisant seulement 1,8 % de données de haute qualité pour entraîner un modèle de 8 milliards de paramètres, les performances dépassent déjà celles du SOTA actuel des modèles de récompense de 70 milliards de paramètres, prouvant ainsi les avantages de l'ensemble de données Skywork-SynPref en termes de volume et de qualité.

Adresse HuggingFace :

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

Adresse GitHub :

https://github.com/SkyworkAI/Skywork-Reward-V2