4 जुलाई 2025 को, कुंलुन वैनवेस ने द्वितीय पीढ़ी के पुरस्कार मॉडल स्काईवर्क-रिवॉर्ड-वी2 श्रृंखला के ओपन सोर्स करने के लिए आगे बढ़ा। इस श्रृंखला में विभिन्न बेस मॉडल पर आधारित 8 पुरस्कार मॉडल हैं, जिनके पैरामीटर के आकार 6 अरब से 80 अरब तक हैं। जैसे ही यह श्रृंखला जारी की गई, यह सात प्रमुख पुरस्कार मॉडल मूल्यांकन बिंदुओं पर व्यापक रूप से शीर्ष पर रही, और ओपन सोर्स पुरस्कार मॉडल के क्षेत्र में केंद्र बिंदु बन गई।

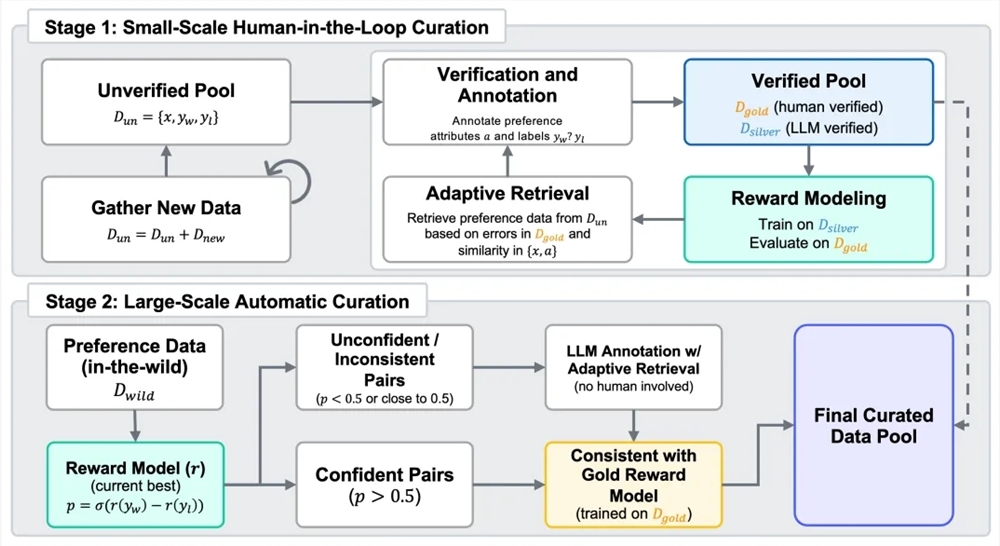

मानव प्रतिक्रिया से अधिकतम शिक्षा (RLHF) प्रक्रिया में पुरस्कार मॉडल की आवश्यकता होती है। एक नई पीढ़ी के पुरस्कार मॉडल बनाने के लिए, कुंलुन वैनवेस ने 40 मिलियन प्राथमिकता तुलना वाले मिश्रित डेटा सेट स्काईवर्क-सिनप्रेफ-40एम का निर्माण किया। डेटा प्रसंस्करण में, टीम ने मानव-मशीन सहयोग की दो चरण की प्रक्रिया का उपयोग किया, जिसमें उच्च गुणवत्ता वाले मानव निर्देश और मॉडल की पैमाने पर उत्पादन क्षमता को जोड़ा गया। पहले चरण में, अज्ञात प्राथमिकता टैंक का निर्माण किया गया, बड़े भाषा मॉडल के साथ सहायता के लिए अतिरिक्त गुण उत्पन्न किए गए, फिर मानव निर्देशकों ने सख्त समझौतों और बाहरी उपकरणों, बड़े भाषा मॉडल के साथ डेटा के कुछ हिस्सों की ध्यान से समीक्षा करके छोटे आकार के उच्च गुणवत्ता "स्वर्ण मानक" डेटा सेट का निर्माण किया। फिर स्वर्ण मानक डेटा के प्राथमिकता टैग के निर्देश पर, बड़े भाषा मॉडल के साथ बड़े पैमाने पर उच्च गुणवत्ता "चांदी मानक" डेटा उत्पन्न किया गया, और बार-बार अद्यतन के माध्यम से अद्यतन किया गया। दूसरे चरण में, स्वचालित बड़े पैमाने पर डेटा विस्तार की ओर ध्यान केंद्रित किया गया, जिसमें प्रशिक्षित पुरस्कार मॉडल के साथ एकरूपता फ़िल्टर किया गया, जिससे मानव निर्देशकों के भार को कम करते हुए प्राथमिकता डेटा के आकार और गुणवत्ता के बीच संतुलन बनाए रखा गया।

उच्च गुणवत्ता वाले मिश्रित प्राथमिकता डेटा पर विकसित स्काईवर्क-रिवॉर्ड-वी2 श्रृंखला के विस्तृत उपयोग और उत्कृष्ट क्षमता दिखाई दी। यह मानव प्राथमिकता के सामान्य समायोजन, वस्तुनिष्ठ सहीता, सुरक्षा, शैली विरोधी क्षमता और best-of-N विस्तार क्षमता के विभिन्न पहलुओं को कवर करता है। Reward Bench v1/v2, PPE Preference & Correctness, RMB, RM-Bench, JudgeBench आदि सात प्रमुख पुरस्कार मॉडल मूल्यांकन मानकों पर यह वर्तमान में सबसे अच्छा (SOTA) स्तर तक पहुंच गई। यहां तक कि सबसे छोटे मॉडल Skywork-Reward-V2-Qwen3-0.6B के लिए, समग्र क्षमता लगभग पिछले पीढ़ी के सबसे मजबूत मॉडल के औसत स्तर तक पहुंच गई, और Skywork-Reward-V2-Qwen3-1.7B वर्तमान ओपन सोर्स पुरस्कार मॉडल के SOTA को पार कर गया। सबसे बड़े आकार के Skywork-Reward-V2-Llama-3.1-8B ने सभी प्रमुख मानक परीक्षणों में व्यापक रूप से ऊपर रहा, और वर्तमान में सबसे अच्छा ओपन सोर्स पुरस्कार मॉडल बन गया।

इस श्रृंखला के मॉडल में बहुआयामी मानव प्राथमिकता की व्यापक क्षमता भी है। जनरल प्राथमिकता मूल्यांकन बेंचमार्क पर, यह कई बड़े पैरामीटर मॉडल और नवीनतम जनक पुरस्कार मॉडल के आगे रहा; वस्तुनिष्ठ सहीता मूल्यांकन में, ज्ञान-घनत्व वाले कार्यों में उत्कृष्ट प्रदर्शन दिखाया; उच्च श्रेणी की कई क्षमताओं में, जैसे Best-of-N कार्य, विवेक विरोधी क्षमता परीक्षण, जटिल निर्देश अवधारणा और वास्तविकता का निर्णय आदि में अग्रणी प्रदर्शन प्राप्त किया, जो अद्भुत सामान्यीकरण क्षमता और उपयोगिता को दर्शाता है।

इसके अतिरिक्त, डेटा चयन प्रक्रिया की उच्च विस्तार क्षमता ने पुरस्कार मॉडल के प्रदर्शन को व्यापक रूप से बढ़ा दिया। ध्यान से चयनित और फ़िल्टर किए गए प्राथमिकता डेटा, कई बार अद्यतन प्रशिक्षण में मॉडल के समग्र प्रदर्शन को लगातार प्रभावी ढंग से बढ़ा देता है, विशेष रूप से दूसरे चरण में पूर्ण रूप से स्वचालित डेटा विस्तार में उल्लेखनीय प्रदर्शन दिखाया। शुरुआती संस्करण परीक्षण दर्शाते हैं कि केवल 1.8% उच्च गुणवत्ता वाले डेटा के साथ 8 बिलियन स्केल मॉडल के प्रशिक्षण से, प्रदर्शन वर्तमान 70 बिलियन स्केल SOTA पुरस्कार मॉडल को पार कर गया, जो स्काईवर्क-सिनप्रेफ डेटा सेट के आकार और गुणवत्ता के लाभ को साबित करता है।

HuggingFace पता:

https://huggingface.co/collections/Skywork/skywork-reward-v2-685cc86ce5d9c9e4be500c84

GitHub पता:

https://github.com/SkyworkAI/Skywork-Reward-V2