人工知能分野において、報酬モデルは大規模言語モデル(LLMs)と人間のフィードバックを一致させるために不可欠な要素ですが、既存のモデルには「報酬ハッカー」問題が存在しています。

これらのモデルは、回答の長さやフォーマットなどの表面的な特徴に焦点を当て、真の品質指標である事実の正確性や関連性を識別することはありません。この問題の根本原因は、標準的な学習目標が訓練データ内の偽の相関関係と本物の因果的要因を区別できないことです。このような失敗により、脆弱な報酬モデル(RMs)が生成され、不一致な戦略が生まれます。この問題を解決するためには、因果理解を利用してRMsを訓練する新しい方法が必要であり、因果的品質属性に敏感で、さまざまな偽の手がかりに対して安定したモデルを作成する必要があります。

現在の報酬モデルの手法は、Bradley-Terry法や対比較ランキング法に基づく標準的なRLHFシステムにおける報酬ハッカー問題を解決しようと試みています。これにはアーキテクチャの変更、戦略レベルの調整、または集合や一貫性チェックに関わるデータ中心の方法が含まれます。最近では、MMD正則化を使って事前に指定された偽の要因に対処したり、因果効果を修正して推定する因果的なヒューリスティックな方法が使われています。しかし、これらの方法は事前に決定された偽の要因のみを対象としており、未知の相関関係には対応できません。また、強化された戦略はまだ粗いままであり、評価中心の方法は報酬モデルにとって多様な偽の変異に対処する強力な訓練メカニズムを提供できていません。

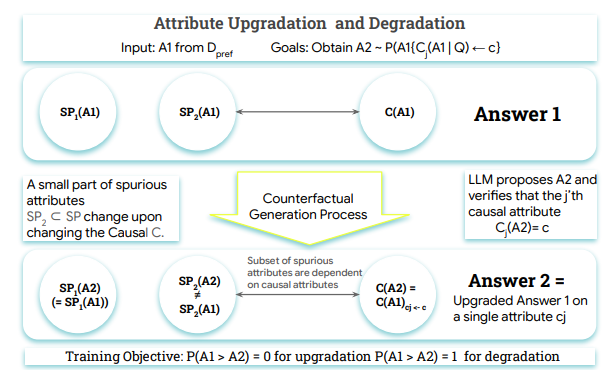

こうした課題に対応するために、グーグルDeepMind、マギル大学、MILA-ケベックAI研究所の研究者たちはCrome(因果的ロバスト報酬モデリング)を提案しました。Cromeフレームワークは、答えの生成に関する明確な因果モデルに基づいており、大規模言語モデルによって生成されたターゲット付きの反事実例を含む好みデータセットを追加することで、真の品質の駆動要因と表面的な手がかりを区別するようにRMsを訓練します。さらに、Cromeは2種類の合成トレーニングペアを作成します。それは因果的拡張(Causal Augmentations)と中立的拡張(Neutral Augmentations)であり、モデルのロバスト性を向上させ、報酬ベンチマークの精度を最大限に高めます。

Cromeの操作は2つの主要な段階に分けられます。1つ目は因果モデルに基づいて属性感知型の反事実データを生成すること、そして2つ目は組み合わせたデータ上で専用損失関数を使用して報酬モデルを訓練することです。性能評価では、Gemma-2-9B-IT、Qwen2.5-7Bなど複数のベースLLMを用い、顕著な性能向上を達成しました。

Cromeは複数のベンチマークで優れた結果を示し、特に安全性と推論能力において明確な進歩を遂げました。さらに、WildGuardTestでも良好なパフォーマンスを示し、有害なプロンプトに対する攻撃成功率を低下させながら、良性のプロンプトに対する拒否率は維持しています。

今後、Cromeの研究方向は因果的データ拡張に注力され、合成データ生成を通じて基礎モデルのトレーニングに新たな可能性をもたらすことが予想されます。

論文:https://arxiv.org/abs/2506.16507

ポイント:

🌟 CromeフレームワークはグーグルDeepMindなどの機関が開発したもので、報酬モデルのロバスト性を向上させる目的を持っています。

📈 Cromeは因果的拡張と中立的拡張の戦略を通じて、モデルの様々なタスクでのパフォーマンスを大幅に向上させています。

🔒 Cromeはセキュリティテストで優れた結果を示し、攻撃成功率を低下させ、モデルの信頼性を向上させています。