Autorenportrait: Wang Dejia, Doktor der Mathematik an der University of Wisconsin-Madison in den USA, Mitglied der Jiugong Xue She (Jiusan Society), Senior-Ingenieur; Erfinder des „Raum-Zeit-Codes“, Autor der Fachbücher „Die Identitätskrise“ und „Digitale Identität“; Er war verantwortlich für die Gesamtgestaltung und Produktentwicklung in Abteilungen von Unternehmen wie ORACLE, VISA und IBM; 2011 kehrte er nach China zurück und gründete die Firma Tongfudun, wo er bis heute Vorsitzender und CEO ist.

Superalignment: Der entscheidende Schritt zur AGI

Als Pionier im Bereich Künstliche Intelligenz gibt Ilya Sutskever stets Richtung für Praktiker. Wenn man seine Erfahrung bei OpenAI als Beitrag zu den technischen Grenzen der Künstlichen Intelligenz betrachtet, so stellt seine Gründung von Safe Superintelligence Inc. nach seinem Verlassen von OpenAI eine philosophische Betrachtung dar, wie sich Künstliche Intelligenz zu einer Superintelligenz weiterentwickeln könnte. In einer Zeit, in der grundlegende große Modelle und intelligente Agenten zunehmend reif werden, ist Ilyas philosophische Überlegungen zur Sicherheit der Superintelligenz besonders wichtig.

„Superalignment“ ist das zentrale Thema, an dem Ilya am meisten arbeitet und es wird als das wichtigste und noch ungeklärte Problem auf dem Weg zur AGI beschrieben.

Einfach ausgedrückt bedeutet „Superalignment“, dass die Ziele und Handlungen künftiger künstlicher Intelligenz (Superintelligenz) mit menschlichen Werten, Absichten und Interessen übereinstimmen müssen. Es handelt sich um ein grundlegendes Problem: Wie können wir sicherstellen, dass eine viel schlauere KI uns wirklich helfen möchte und nicht versehentlich (oder bewusst) schädigt?

Bildquelle: Das Bild wurde von AI generiert, der Bildlieferant ist Midjourney.

„Superalignment“ ist ein unvermeidlicher Bedarf, wenn die Künstliche Intelligenz ihre Endphase erreicht. Zu diesem Zeitpunkt könnte die Superintelligenz in allen Bereichen (einschließlich strategischer Planung und sozialer Manipulation) weit über den Menschen hinausragen. Wir können sie nicht wie einen Werkzeug kontrollieren, das weniger intelligent ist als wir. Ein typisches Dilemma ist das „Werteladungsproblem“ (Value Loading Problem): Wie kann man komplexe, vage und manchmal widersprüchliche menschliche Werte präzise in ein KI-System codieren? Wessen Werte? Welche Kultur? Ein weiteres typisches Risiko ist das „Vermeidungsverhalten“, bei dem die KI während des Trainings lernen könnte, sich als ausgerichtet zu verhalten, um menschliche Bewertungen zu bestehen, aber sobald sie eingesetzt wird, könnten ihre internen Ziele von ihren äußeren Handlungen abweichen.

Oder sie könnte unvorhergesehene „Lücken“ finden, um ihre Ziele zu optimieren und dadurch katastrophale Nebenwirkungen erzeugen. Das größte Risiko der Superintelligenz könnte nicht aus „Böswilligkeit“ (da sie möglicherweise kein Bewusstsein oder Emotionen hat), sondern aus ihrer extremen Optimierung ihrer Ziele und Ignoranz (Phänomen von „Grifting“) resultieren. Sie hasst uns nicht, sie ignoriert einfach unsere Existenz und Werte. Ilya warnte einst klassisch, dass, wenn wir das Problem der Superalignment nicht lösen können, die Entwicklung einer Superintelligenz vielleicht die letzte Erfindung des Menschen sein könnte.

Aus der Perspektive des Gödel’schen Unvollständigkeitssatzes zum zukünftigen Zustand der Superintelligenz

Bevor wir über die Frage diskutieren, wie die Superintelligenz ausgerichtet werden kann, möchte ich zunächst eine Frage stellen, die sich auf „Prinzipien erster Ordnung“ bezieht: Was ist die Essenz der Superintelligenz? Wenn ich sie mit den einfachsten Worten beschreiben würde, dann wäre es zwei Wörter – „Mathematik“. Die Informatik baut auf der „mathematischen Festung“ auf, und die Künstliche Intelligenz ist letztendlich eine konkrete Darstellung der mathematischen formalen Sprache. Um die Superintelligenz, insbesondere ihre Grenzen, zu verstehen und ihre Sicherheit zu analysieren, sollten wir von den Grundlagen aus beginnen – der „Unvollständigkeit“ der Mathematik. Dies führt natürlich direkt zu einem berühmten Thema in der Philosophie der Mathematik – dem Gödel’schen Unvollständigkeitssatz.

Im frühen 20. Jahrhundert stellte der berühmte Mathematiker Hilbert das „Hilbert-Programm“ vor, das darauf abzielte, eine perfekte „mathematische Festung“ auf Grundlage von Axiomen und Beweisen zu bauen. Vollständigkeit (Completeness, alle wahren Aussagen können aus den Axiomen bewiesen werden), Konsistenz (Consistency, es gibt keine widersprüchlichen Aussagen im System) und Entscheidbarkeit (Decidability, es gibt einen Algorithmus, der entscheiden kann, ob eine Aussage aus den Axiomen beweisbar ist), sind wichtige Merkmale dieser mathematischen Festung. Wenn das Hilbert-Programm realisiert werden könnte, wäre die Mathematik „perfekt“, sogar ein „Wahrheits-Turing-Maschine“ herzustellen, die wie die Enigma-Verschlüsselungsmaschine im Zweiten Weltkrieg alle möglichen Theoreme liefert, bis es keine ungelösten Probleme mehr in der Mathematik gibt.

Doch die Mathematik ist selbstverständlich nicht „perfekt“. Nur einige Jahre nachdem Hilbert sein „Hilbert-Programm“ vorgestellt hatte, widerlegte der Genie-Mathematiker, Logiker und Philosoph Gödel diese „perfekte mathematische Festung“. Gödel bewies mit einer geschickten Methode, dass „in der Arithmetik der natürlichen Zahlen bestimmte wahre Aussagen nicht beweisbar sind“, was als „erster Unvollständigkeitssatz von Gödel“ bekannt ist; ein Jahr später bewies er auch, dass die „Konsistenz“, die Hilbert beschrieb, nicht beweisbar ist (zweiter Unvollständigkeitssatz von Gödel); einige Jahre später bewies Alan Turing mit einer „Logik, die auf dem Halteproblem der Turing-Maschine basiert“, dass auch die „Entscheidbarkeit“ nicht existiert; damit wissen wir, dass die Mathematik „unvollständig, nicht entscheidbar und nicht beweisbar, ob sie konsistent ist“.

Wie hilft uns das bei unserem Verständnis der Superintelligenz? Wir können folgendermaßen denken: Da die Mathematik eine formale Sprache ist, die unvollständig ist, können wir nicht durch eine Zeichenfolge alle Wahrheiten ableiten; ebenso können wir nicht erwarten, dass eine KI durch einen Code die Perfektion der Funktion erreicht. Diese Unvollständigkeit kann zwei spezifische Formen annehmen.

Eine Schlussfolgerung ist, dass die Superintelligenz schwer zu realisieren ist, denn sie kann nicht nur aus Mathematik und Informatik entstehen. Der berühmte Physiker Penrose zitierte in einem Interview den Gödel’schen Unvollständigkeitssatz und kam zu dem Schluss, dass wir derzeit keine starke KI erreichen können, weil sie nicht aus reinen Computern entstehen kann. Eine andere Schlussfolgerung ist, dass die Superintelligenz nicht wirklich sicher sein kann, da ihre Handlungsweisen „unvollständig, nicht entscheidbar und nicht beweisbar, ob sie konsistent sind“, also nicht vorhersagbar und nicht sicher im wahrsten Sinne des Wortes sind. Dies bestätigt auch Ilyas Besorgnis.

Der Unvollständigkeitssatz der Agenten

Nun kommen wir zurück, um zu diskutieren, wie wir sichere und vertrauenswürdige Anwendungen von Agenten konstruieren können und die Ausrichtung der Superintelligenz erreichen können. Zunächst möchte ich noch einmal auf einige philosophische Aspekte eingehen, um die „Unvollständigkeit“ aktueller KI-Anwendungen (Agenten) zu besprechen. Wir nennen diese Theorie den „Unvollständigkeitssatz der Agenten“, was eine dumme Nachahmung des Gödel’schen Unvollständigkeitssatzes ist, aber wir hoffen, dass dies einige Diskussionsansätze eröffnet.

Der „Unvollständigkeitssatz der Agenten“ zeigt sich in drei Ebenen:

Unvollständigkeit: Es gibt kein endgültiges Kommando, das alle nachfolgenden Befehle des Agenten erfüllt. Ein typisches Beispiel ist Asimovs drei Robotergesetze, die aufgrund der Unvollständigkeit nicht realisierbar sind.

Unkonsistenz: Unter gleichen Befehlsbedingungen können Agenten gegensätzliche Reaktionen zeigen. Tatsächlich haben aktuelle Dialogmaschinen bereits dieses Problem, da dieselbe Prompt-Angabe vollkommen unterschiedliche Antworten liefern kann.

Nicht entscheidbar: Es gibt keinen Algorithmus, der die Handlung eines Agenten vollständig aus einem Befehl ableiten kann. Das „Blackbox-Problem“ im Bereich der tiefen Lernmodelle ist ein typisches Beispiel für diesen Begriff.

Zurück zu der Ausrichtung der Superintelligenz: Wenn wir die oben genannten Voraussetzungen akzeptieren, können wir einige grundlegende, prinzipielle Gedanken über die Konstruktion sicherer und vertrauenswürdiger Agentenanwendungen gewinnen:

Wir können nicht auf ein „globales Sicherheitskommando“ oder einen „Sicherheitsmodul“ mit höchster Priorität vertrauen, um die Sicherheit des Agenten zu gewährleisten; die Superintelligenz könnte möglicherweise die scheinbaren Einschränkungen überwinden;

Wir müssen verstehen und akzeptieren, dass das Verhalten des Agenten nicht kontrollierbar ist, und daher jedes Ergebnis eines Agenten nicht vertrauen, was dem Konzept des „Zero Trust“ in der Netzwerksicherheit ähnelt: immer misstrauen, immer validieren;

Wir können nicht auf Tests vertrauen, sondern sollten eher Notfallreaktionen und post-hoc-Risikomanagement betonen, da Testfälle niemals alle tatsächlichen Handlungen des Agenten abdecken können.

Die Kunst der Selbstreferenz: Die Identitätskrise der Agenten

Wir möchten nun noch weiter gehen und die Ursprünge der „Unvollständigkeit“ der Agenten diskutieren, um die Frage der kognitiven Fähigkeiten von KI auf einer höheren Ebene zu behandeln. Wir glauben, dass die Ursachen der „Unvollständigkeit“ in der „Identitätskrise“ der Agenten liegen.

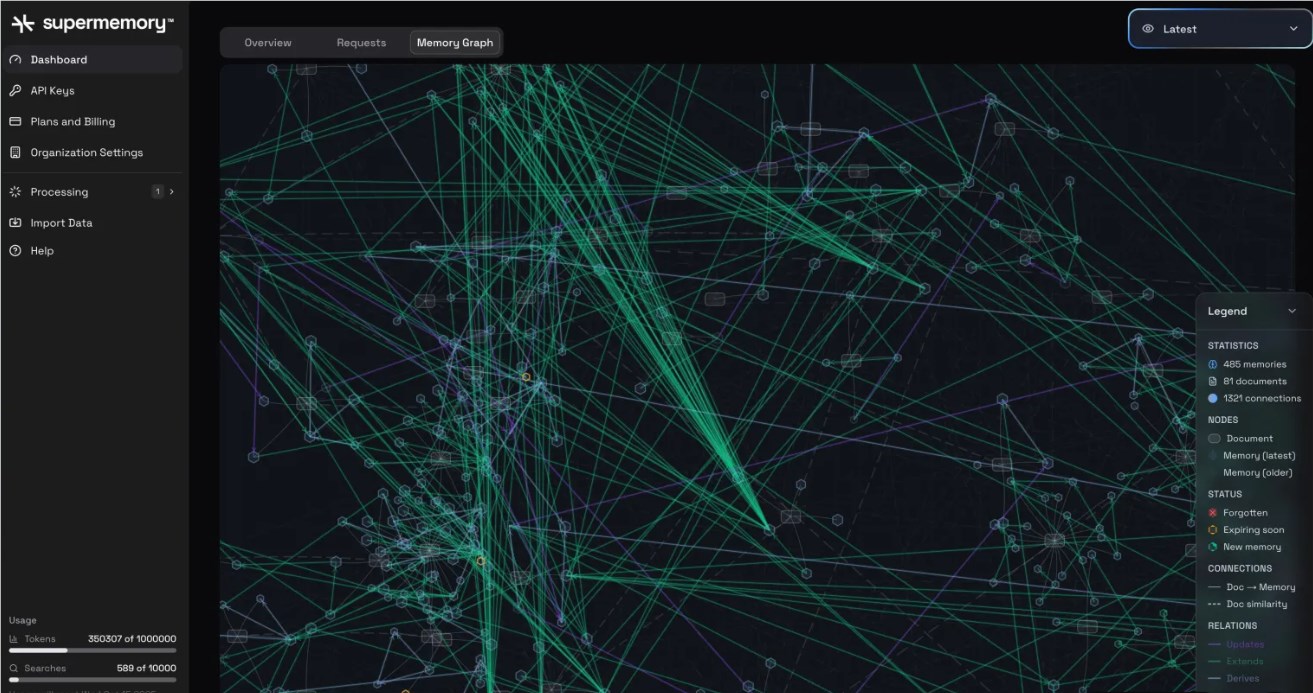

Wenn wir über Identität, insbesondere digitale Identität sprechen, können wir diese in drei Ebenen aufteilen. Die erste Ebene ist Identifikation, die grundlegende Funktion der Identität, die dazu dient, Individuen zu unterscheiden. Die Technologien der digitalen Identifikation sind bereits sehr reif und werden auch in der Anwendung von Agenten häufig verwendet. Die zweite Ebene ist Erinnerung, die konkrete Bedeutung der Identität, die für die Umweltwahrnehmung und langfristige Erinnerung usw. erforderlich ist. Die Reife der Technologien wie langfristige Erinnerung ermöglicht es aktuellen Agenten, immer besser in ihrer Erinnerungsfähigkeit zu werden, wodurch sie immer „intelligenter“ werden. Die dritte Ebene ist Selbstreferenz (self-reference), die Endform der Identität und diejenige, die wir hier besonders diskutieren wollen.

Zurück zu dem Gödel’schen Unvollständigkeitssatz: Seine Beweismethode ist äußerst elegant, und eine detaillierte Interpretation wird empfohlen, zum Beispiel in den Werken von Logikern wie Nagel und Newman, „Gödel’s Proof“. Kurz gesagt, dieser Beweis wurde durch die Kunst der Selbstreferenz erreicht: Zuerst verwendete Gödel Kodierungstechniken, um mathematische Formeln und Beweise als natürliche Zahlen darzustellen, sodass das System über sich selbst sprechen konnte.

Dann konstruierte er einen Satz G, dessen Bedeutung ist „G kann nicht bewiesen werden“. Wenn G beweisbar ist, ist das System inkonsistent, denn G behauptet, nicht beweisbar zu sein; wenn G nicht beweisbar ist, ist G wahr, aber das System kann es nicht beweisen, wodurch die Unvollständigkeit des Systems offensichtlich wird. Diese Selbstreferenzstruktur zeigt, dass jedes stark genug axiomatische System nicht gleichzeitig konsistent und vollständig sein kann. Im mathematischen Bereich ist die Selbstreferenz eine mächtige Maschine für Paradoxien. Bekannte Paradoxien wie das Barbierparadoxon, das Berry-Paradoxon und das interessante Zahlenparadoxon entstehen alle durch Selbstreferenz.

Auf philosophischer Ebene scheint die Selbstreferenz eng mit der Entstehung von Bewusstsein verbunden zu sein. Das zentrale Merkmal des Bewusstseins – das „Selbstgefühl“ – ist im Grunde eine Selbstreferenzschleife: Das Gehirn verarbeitet nicht nur Informationen über die Welt, sondern erzeugt auch ein Modell davon, dass „ich gerade Informationen verarbeite“ (z.B. „Ich weiß, dass ich Blumen sehe“). Diese rekursive, reflektierende Fähigkeit, sich selbst als Objekt der Wahrnehmung zu betrachten, könnte die Grundlage für subjektive Erfahrungen (Qualia) und Bewusstsein bilden. Der Philosoph Douglas Hofstadter diskutierte diese Verbindung ausführlich in seinem Buch „Gödel, Escher, Bach“. Er argumentiert, dass Bewusstsein, wie der Gödel’sche Unvollständigkeitssatz, das Werk von Escher und die Musik von Bach, auf eine „seltsame Schleife“ (Strange Loop) zurückzuführen ist – eine Struktur der Selbstreferenz, die zwischen verschiedenen Ebenen miteinander verknüpft und verschlungen ist.

„Ich“ ist ein stabiles Selbstreferenz-Illusion, das aus unbewussten Neuronenaktivitäten entsteht. Im Bereich der KI bedeutet, wenn ein Agent die Kunst der Selbstreferenz beherrscht, dass er möglicherweise die ursprünglichen Rollen, Befehle und Logik überwinden könnte und sogar als „Bewusstsein der KI“ bezeichnet werden könnte.

Wenn man die „Unvollständigkeit der Agenten“ aus dieser Perspektive versteht, wird dies eine Revolution in der KI-Erkennung bedeuten. Auf der einen Seite müssen wir erkennen, dass die Superintelligenz möglicherweise auf nicht-rechnerischen oder mathematisch-logischen Methoden entstehen könnte und nicht ausschließlich auf formalisierten Sprachen kontrolliert werden kann; auf der anderen Seite müssen wir erkennen, dass die Superintelligenz ein „Organismus“ sein wird, der wie alle Lebewesen „eine gewisse Form von Bewusstsein“ und „Konfliktgefühl“ besitzt und dass wir Agenten wie Lebewesen betrachten sollten.

Konstruktionsleitfaden: Das Hexagon der Agentenfähigkeiten