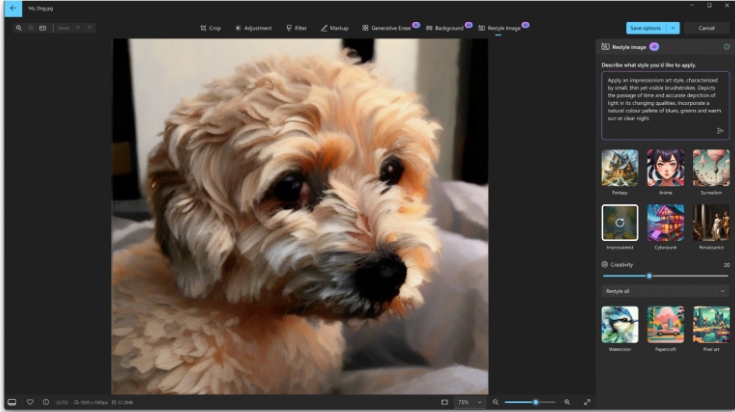

A DeepMind anunciou hoje uma funcionalidade revolucionária chamada "edição precisa" para seu modelo líder de geração de vídeos, o Veo. Essa funcionalidade permite que os usuários adicionem ou removam elementos, como objetos, personagens ou objetos no fundo, em vídeos existentes por meio de simples dicas de texto, enquanto reconstrói inteligentemente a cena para garantir realismo físico e coesão visual, preservando perfeitamente a integridade do vídeo original.

Segundo relato da AIbase, essa atualização marca a transição da edição de vídeos de IA de geração grossa para processamento pós-preciso, aumentando significativamente a eficiência de produção dos criadores na plataforma Flow. A funcionalidade de edição precisa do Veo é parte da atualização Veo3.1, projetada especificamente para as ferramentas de produção cinematográfica de IA da Google, o Flow. Ela utiliza algoritmos avançados de IA generativa, considerando luz, proporção, interação de objetos e trajetórias de movimento, para realizar modificações sem falhas.

Por exemplo, os usuários podem indicar "adicionar um ônibus amarelo à cena" ou "remover uma pessoa ao lado da estrada", e o modelo preenche automaticamente o fundo, ajusta as sombras e mantém a consistência do movimento da câmera, evitando problemas comuns em softwares de edição tradicionais, como "pulos de quadro" ou marcas não naturais. No vídeo de demonstração, essa funcionalidade mostrou todo o processo, desde imagens estáticas até narrativas dinâmicas com múltiplos planos, permitindo que os usuários iterem rapidamente o conteúdo em alguns segundos, sem precisar regravar ou usar máscaras manuais.

Segundo análise da AIbase, os principais inovadores do Veo3.1 incluem sincronização de áudio aprimorada, geração de cenas com múltiplas dicas e saída nativa em 1080p, suportando o aumento do comprimento do vídeo até 1 minuto. Isso torna a edição precisa útil tanto para criadores de curtas quanto para anúncios, marketing e treinamentos corporativos. Por exemplo, na plataforma Flow, os usuários podem carregar "componentes" (como personagens definidos ou referências de estilo), e depois usar a edição precisa para expandir os planos, automatizando a transição de uma única imagem para um storyboard completo. Em comparação com o Veo3 anterior, essa versão melhorou em mais de 30% a consistência dos personagens e o controle da narrativa, e testes básicos mostraram uma taxa de precisão de edição de 95%, significativamente superior aos concorrentes, como o Sora2 da OpenAI. “A edição precisa torna a criação de vídeos de IA verdadeiramente democrática, permitindo que os usuários realizem modificações de nível hollywoodiano sem necessidade de habilidades profissionais,”