L'intelligence artificielle bouleverse tous les secteurs à une vitesse étonnante, et le domaine de la production vidéo ne fait pas exception. Récemment, l'émergence de modèles de génération de vidéos par IA a suscité un intérêt considérable, certains allant jusqu'à affirmer qu'elle révolutionnera l'avenir d'Hollywood.

Cependant, quelles sont les capacités réelles de cette technologie ? Des chercheurs de l'Université chinoise de Hong Kong et de Tencent, par le biais du projet « VideoGen-Eval », ont procédé à une évaluation complète des principaux modèles actuels de génération de vidéos par IA, révélant ainsi le niveau réel de cette technologie émergente.

L'équipe de recherche a testé les modèles de génération de vidéos par IA selon plusieurs critères, notamment la cohérence entre le texte et la vidéo, la composition des images, les transitions de scènes, la créativité, la stylisation, la stabilité et la diversité des mouvements. Les résultats montrent que, si l'IA a fait des progrès significatifs dans certains domaines, il reste encore un long chemin à parcourir avant la perfection.

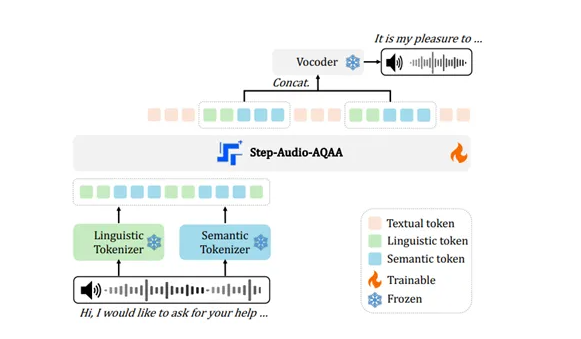

Comparaison des principaux modèles vidéo :

En matière de génération de vidéo à partir de texte (T2V), Gen-3, Kling v1.5 et Minimax se distinguent, Minimax excellant particulièrement dans le contrôle du texte, notamment pour les expressions faciales, les mouvements de caméra, la génération de plans multiples et la dynamique des sujets.

Gen-3 excelle dans le contrôle de la lumière, des textures et des techniques cinématographiques, tandis que Kling v1.5 trouve un bon équilibre entre effets visuels, contrôlabilité et capacités de mouvement.

Pika 1.5 se distingue par la génération d'effets vidéo spécifiques, tels que l'expansion, la fusion et l'explosion.

Exemples de vidéos :

Invite : Caméra statique, une boule de verre roule sur une table lisse

Invite : Vue aérienne FPV, le soleil brille sur les montagnes enneigées, atmosphère calme

Invite : Zoom hyper-rapide sur une rose rouge et mise en valeur des détails de ses pétales

Les modèles de génération de vidéos par IA actuellement disponibles se répartissent en deux catégories : propriétaires et open source. Les modèles propriétaires sont l'équivalent des secrets de fabrication des entreprises de haute technologie, comme Gen-3 de Runway et Dream Machine de LumaLabs. Ces modèles produisent généralement des vidéos de meilleure qualité et plus performantes, mais leur accès est payant.

Les modèles open source, quant à eux, sont comparables aux manuels d'arts martiaux accessibles à tous. Open-Sora et EasyAnimate, par exemple, bien que leurs résultats soient peut-être moins performants que ceux des modèles propriétaires, ont l'avantage d'être gratuits et ouverts, permettant à chacun d'y contribuer.

Le projet « VideoGen-Eval » a testé divers modèles de génération de vidéos par IA, notamment la génération de vidéo à partir de texte (T2V), d'image à vidéo (I2V) et de vidéo à vidéo (V2V). Les résultats ont révélé que, si ces modèles ont fait de grands progrès dans certains domaines, tels que la qualité d'image, le naturel des mouvements et la correspondance avec les descriptions textuelles, ils sont encore loin de la perfection que nous imaginons !

Commençons par les points positifs : l'IA est désormais capable de générer des vidéos simples. Par exemple, si vous entrez « un ours en peluche se promène dans un supermarché, la caméra tourne dans le sens inverse des aiguilles d'une montre », l'IA peut générer une vidéo d'un ours en peluche avec une caméra en rotation. Cela semble magique, n'est-ce pas ? Cependant, si vous souhaitez que l'IA génère des scènes complexes, telles que « une personne nage dans une piscine, des éclaboussures d'eau » ou « trois singes sautent dans une forêt, deux perroquets volent dans les arbres », l'IA commence à être dépassée.

Cela est principalement dû au fait que la compréhension par l'IA des lois physiques, des relations spatiales et des propriétés des objets est encore insuffisante. Par exemple, si vous demandez à l'IA de générer une vidéo d'« une boule de verre roulant sur une table », l'IA pourrait ne pas savoir comment la boule devrait rouler pour respecter les lois de la physique, et la vidéo générée sera donc étrange.

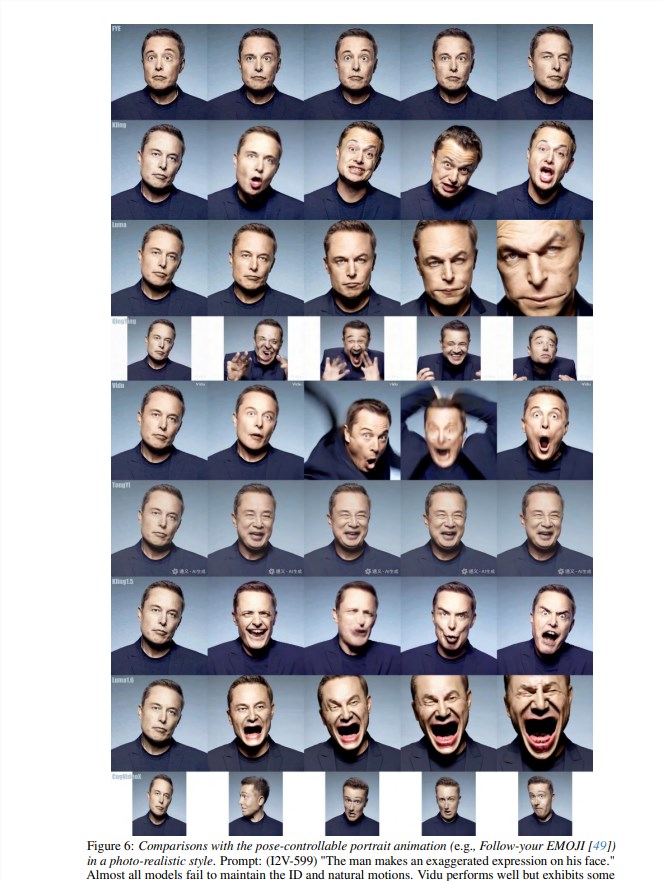

De plus, l'IA rencontre de grandes difficultés à traiter les mouvements rapides, les expressions faciales et les interactions entre plusieurs personnages. Par exemple, si vous souhaitez que l'IA génère une vidéo de baseball, la scène générée pourrait être très étrange, les mouvements des personnages étant complètement incohérents, et la balle pourrait même s'envoler dans le ciel.

N'oublions pas les scènes qui nécessitent de l'imagination et de la créativité de la part de l'IA. Si vous souhaitez que l'IA génère une vidéo d'« une personne entourée de fumée colorée », l'IA ne générera peut-être qu'un tas de couleurs désordonnées, sans qu'il soit possible de discerner quoi que ce soit. En résumé, aucun modèle actuel ne peut atteindre la perfection, et de nombreux défis subsistent dans le traitement des mouvements complexes, des interactions entre plusieurs objets, de la simulation physique, de la compréhension sémantique et du contrôle précis.

Vidéo d'évaluation complète : https://ailab-cvc.github.io/VideoGen-Eval/#text-to-video