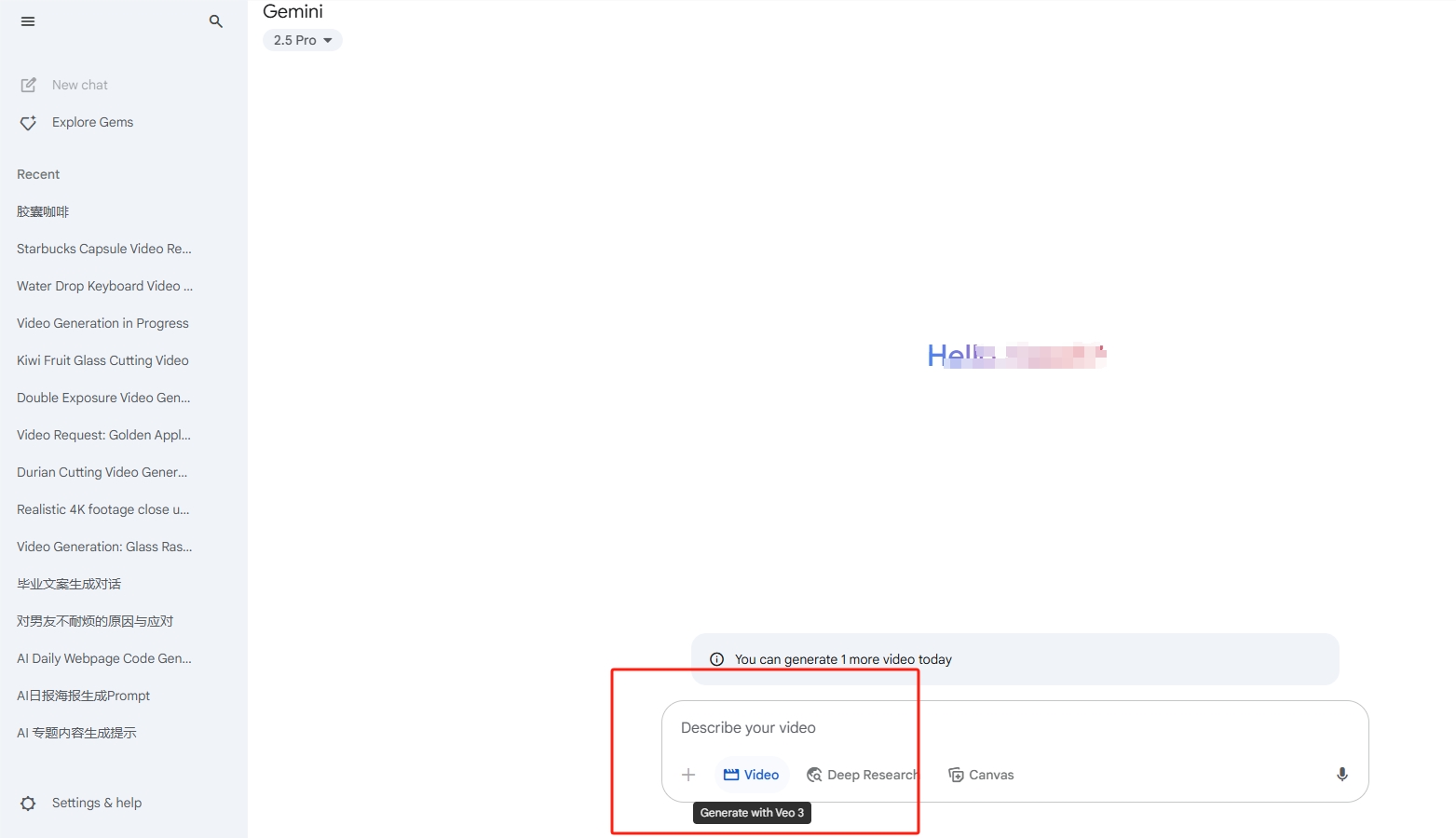

Kürzlich hat Google DeepMind mit dem Modell Gemini 2.5 Pro Aufmerksamkeit in der Technologiebranche erregt. Als eines der führenden KI-Modell für große Sprachmodelle auf dem Markt zeigt Gemini 2.5 Pro mit seiner Fähigkeit, sehr lange Kontexte zu verarbeiten, ein außergewöhnliches Anwendungspotenzial. Dennoch ist die Betriebskosten des Modells immer noch hoch, und auch die Qualität hat noch Raum zur Verbesserung.

Die Kernkompetenz der Gemini-Reihe besteht darin, dass sie extrem lange Kontexte verarbeiten kann. Diese Eigenschaft macht sich besonders in Bereichen wie KI-Programmierung und Informationsrecherche bemerkbar. Im Vergleich zu anderen Modellen kann Gemini 2.5 Pro den gesamten Inhalt eines Projekts auf einmal lesen und somit eine flüssigere und effizientere Benutzererfahrung bieten. Die Einführung dieser Technologie markiert eine neue Phase bei großen Modellen, und die Anwendung langer Kontexte könnte möglicherweise die traditionelle Art und Weise, wie Informationen interagieren, verändern.

In einem Gespräch mit dem Podcaster Logan Kilpatrick betonte der Forschungswissenschaftler von Google DeepMind, Nikolay Savinov, die Bedeutung des Kontexts. Er erklärte, dass die Kontextinformationen, die Nutzer dem Modell geben, die Personalisierung und Genauigkeit des Modells erheblich verbessern können. Das Modell verlässt sich nicht nur auf das Wissen aus der Vortrainingsphase, sondern benötigt auch die sofortigen Eingaben der Nutzer, um seine Antworten zu aktualisieren und anzupassen, um die Aktualität und Relevanz der Informationen sicherzustellen.

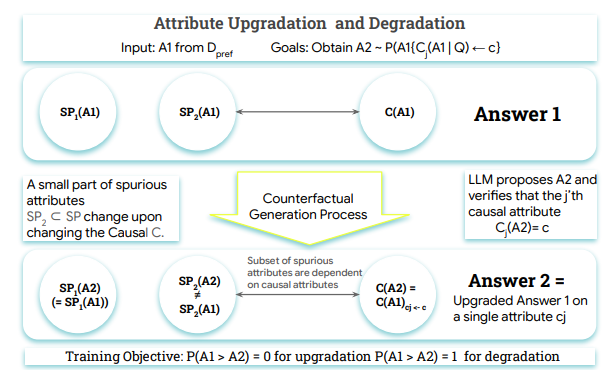

Savino erwähnte auch, dass die RAG-Technik (Retrieval-Augmented Generation) nicht veraltet wird, sondern vielmehr mit langen Kontexten zusammenarbeiten wird. Diese Technik hilft dem Modell in einem Vorverarbeitungsschritt, Informationen schnell aus einer riesigen Wissensbasis zu suchen, wodurch die Rückrufquote der Informationen auf Basis von Millionen von Kontexten weiter gesteigert wird. Die Kombination beider Technologien kann die Leistung des Modells in praktischen Anwendungen erheblich verbessern.

Auch die Zukunft der Technologie langer Kontexte sieht sehr vielversprechend aus. Mit der schrittweisen Reduzierung der Kosten wird voraussichtlich in naher Zukunft die Fähigkeit, Kontexte im Bereich von zehn Millionen Zeichen zu verarbeiten, zur Branchenstandards werden. Dies wird zweifellos revolutionäre Durchbrüche in Bereichen wie AI-Coding und anderen Anwendungen bringen.

Gemini 2.5 Pro trägt nicht nur zur Entwicklung der KI-Technologie bei, sondern eröffnet auch neue Möglichkeiten für die Verbesserung der Benutzererfahrung. Die Anwendung langer Kontexte und ihre Kombination mit der RAG-Technik deuten darauf hin, dass die Zukunft der KI intelligenter und personalisierter werden wird.