中国研究人员推出CogVLM:强大开源视觉语言基础模型

站长之家

本文来自AIbase日报

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

欢迎来到【AI日报】栏目!这里是你每天探索人工智能世界的指南,每天我们为你呈现AI领域的热点内容,聚焦开发者,助你洞悉技术趋势、了解创新AI产品应用。

今日,字节跳动旗下AI原生集成开发环境(IDE)Trae宣布正式开源其核心组件Trae-Agent,为全球开发者带来全新智能编程体验。据官方推文(@Trae_ai)透露,开发者现可通过`git clone`和`cd trae-agent`快速获取并体验这一智能开发助手。Trae-Agent是字节跳动打造的智能开发工具,支持自然语言驱动的编程任务自动化,极大提升开发效率。其核心亮点包括:- **多模型支持**:兼容OpenAI、Anthropic等多种大语言模型,安装配置简便,灵活适配不同开发需求。- **强大功能集成**:内置文件编辑、脚本执行等工具,支

谷歌宣布正式在全球范围内推出其最新的视频生成模型 Veo3。此次发布的消息令广大用户期待已久,Veo3现已向超过159个国家的 Gemini 用户开放,提供全新的视频创作体验。Veo3视频生成模型的特点在于其能够让用户通过简单的文本提示生成最多八秒钟的视频。根据谷歌的介绍,这项技术专为追求创意的用户设计,尤其是对短视频内容需求日益增加的社交媒体用户来说,Veo3将大大简化视频创作过程。不过,值得注意的是,Veo3目前仅对谷歌的 AI Pro 计划付费用户开放,且每日生成视频的数量限制

近日,来自中国人民大学、上海人工智能实验室、伦敦大学学院和大连理工大学的研究团队揭示了大模型推理过程中的一个重要发现:当模型在思考时,所使用的 “思考词” 实际上反映了其内部信息量的显著提升。这一研究成果通过信息论的方法,为我们更好地理解人工智能的推理机制提供了新的视角。你或许见过大模型在解答问题时,会输出一些看似人类化的语言,比如 “嗯……”、“让我想想……” 或 “因此……”。这些 “思考词” 是简单的表面装饰,还是代表着模型真正的思考

近日,法国AI实验室Kyutai宣布,其全新文本转语音模型 Kyutai TTS 正式开源,为全球开发者与研究者带来了一款高性能、低延迟的语音合成解决方案。这一突破性发布不仅推动了开源AI技术的发展,也为多语言语音交互应用开辟了新的可能性。AIbase为您独家解析这一技术亮点及其潜在影响。 超低延迟,实时交互新体验Kyutai TTS以其卓越的性能表现成为业界焦点。该模型支持 文本流式传输,能够在极短时间内生成自然流畅的语音。得益于强大的 L40S GPU 支持,Kyutai TTS能够同时处理多达32个请求,

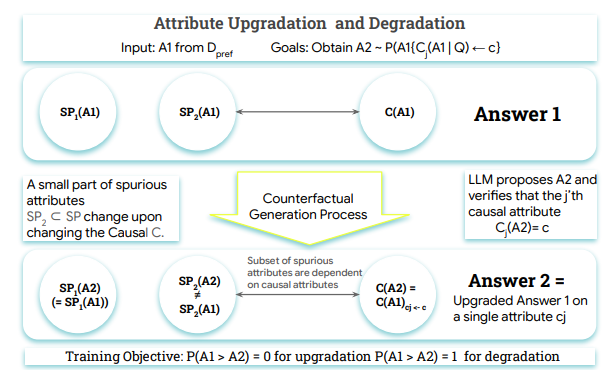

在人工智能领域,奖励模型是对齐大型语言模型(LLMs)与人类反馈的关键组成部分,但现有模型面临着 “奖励黑客” 问题。这些模型往往关注表面的特征,例如回复的长度或格式,而不是识别真正的质量指标,如事实准确性和相关性。问题的根源在于,标准训练目标无法区分训练数据中存在的虚假关联和真实的因果驱动因素。这种失败导致了脆弱的奖励模型(RMs),从而生成不对齐的策略。为了解决这一问题,需要一种利用因果理解来训练 RMs 的新方法,以便对因果质量属性敏感,并对

近日,上海的 AI 独角兽公司 MiniMax 正式推出了全球首个开源大规模混合架构推理模型 ——MiniMax-M1。该模型一经推出,便迅速跻身权威评测榜单,成为全球开源模型的第二名,仅次于近期发布的 DeepSeek-R1-0528。这一里程碑式的成就让 MiniMax 创始人兼 CEO 闫俊杰在社交媒体上感慨:“第一次感觉到大山不是不能翻越。”MiniMax-M1的亮相不仅令人瞩目,其在技术细节上的表现更是出色。该模型在长文本处理和工具调用等方面显示出强大的优势,支持高达100万 token 的上下文输入能力,足以一次性处理

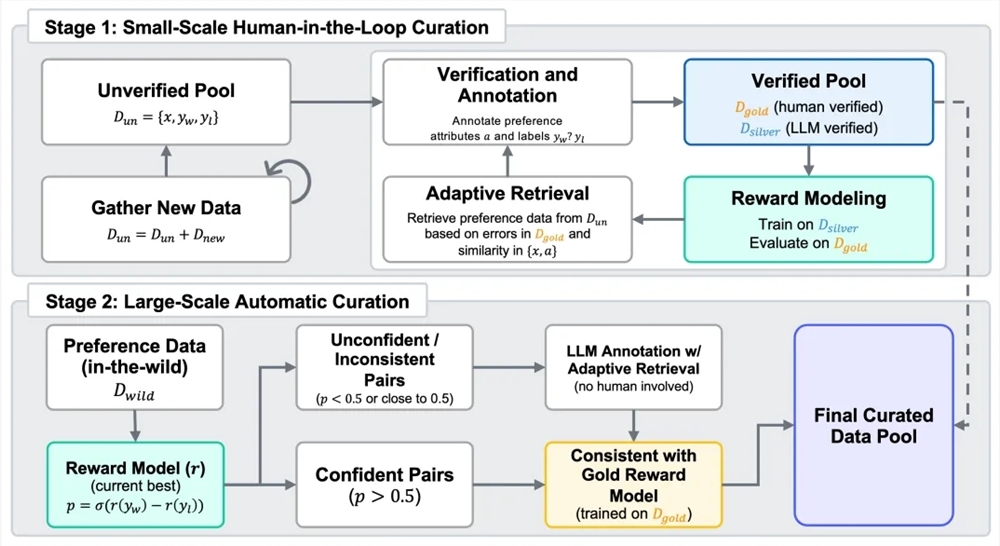

2025年7月4日,昆仑万维乘势而上,继续开源第二代奖励模型Skywork-Reward-V2系列。此系列共包含8个基于不同基座模型、参数规模从6亿到80亿不等的奖励模型,一经推出便在七大主流奖励模型评测榜单中全面夺魁,成为开源奖励模型领域的焦点。 奖励模型在从人类反馈中强化学习(RLHF)过程中起着关键作用。为打造新一代奖励模型,昆仑万维构建了包含4000万对偏好对比的混合数据集Skywork-SynPref-40M。在数据处理上,团队采用人机协同的两阶段流程,将人工标注的高质量与模型的规模化处理能力相结合。第一阶段,先构建未经验证的初始偏好池,借助

谷歌在全球范围内宣布其最新一代AI文生视频模型 Veo3 正式向 Google AI Pro 和 Ultra 会员开放。这款由 Google DeepMind 研发的视频生成模型,以其卓越的高清画质、音画同步能力以及多模态创作功能,迅速成为AI视频生成领域的焦点。Veo3:重新定义AI视频生成在2025年 Google I/O 开发者大会上首次亮相的 Veo3,被誉为谷歌在AI视频生成领域的里程碑式产品。相比前代模型,Veo3在以下方面实现了显著突破:高清画质与物理真实感:Veo3支持生成 1080p 高清视频,内部测试甚至可达 4K 分辨率。其视频画面不仅细节

7月3日,法国AI研究机构Kyutai Labs宣布开源其最新文本转语音(TTS)技术——Kyutai TTS,为开发者与AI爱好者带来高效、实时的语音生成解决方案。Kyutai TTS以低延迟与高保真声音为亮点,支持文本流式传输,无需完整文本即可开始生成音频,特别适合实时交互场景。Kyutai TTS在性能上表现卓越。使用单块NVIDIA L40S GPU,该模型可同时处理32个请求,延迟仅为350毫秒。此外,系统不仅生成高质量音频,还能输出单词的精确时间戳,方便实时字幕生成或交互式应用,如Unmute平台的中断处理功能。在语言

根据毕马威中国最近发布的《首届健康科技50》报告,中国在全球医疗大模型的发布数量上占据了令人瞩目的70% 以上。这一数据不仅展现了中国在智能医疗领域的快速发展,也反映了大语言模型在医疗行业的广泛应用。报告指出,目前已经发布的医疗大模型中,大语言模型的数量占据了约65%。这类模型能够处理和生成自然语言,对于医疗数据的分析、患者交流及科研都有着重要的支持作用。而中国的表现尤为突出,其发布的医疗大模型数量不仅领先于其他国家,更是在全球市场中扮演着关