大規模言語モデル(LLM)は、タスクプロンプトと大規模な強化学習(RL)を組み合わせることで、複雑な推論タスクにおいて顕著な進展を遂げました。例えば、Deepseek-R1-Zeroなどのモデルは、直接的に強化学習を基本モデルに適用し、非常に強力な推論能力を示しています。しかし、この成功は異なる基本モデルシリーズ間で再現するのが難しいことが判明しており、特にLlamaシリーズではその傾向が顕著です。これにより、根本的な問題が生じます:なぜ異なる基本モデルが強化学習の過程で異なる性能を示すのでしょうか。

Llamaモデルにおける強化学習の拡張制限

OpenAIのo1、o3やDeepSeekのR1など、コンペティションレベルの数学問題において大規模な強化学習によって突破を遂げたモデルは、数十億パラメータ以下の小さなモデルの強化学習能力の探求を促進しました。しかし、これらの進展はQwenモデルシリーズに限定され、Llamaなどのモデルでは再現が困難です。予訓練プロセスの透明性が欠如しているため、予訓練が強化学習の拡張に与える影響を理解することが困難です。一部の非伝統的な研究では、一度きりのプロンプトがQwenの推論能力を向上させることを見出しましたが、Llamaにはほとんど効果がありませんでした。OpenWebMathやMathPileなどのプロジェクトが高品質な数学予訓練コーパスの整備に努めているものの、その規模はまだ数百億トークン以下に留まっています。

トレーニング中盤の安定減衰戦略の探求

上海交通大学の研究者たちは、QwenとLlamaを対象に、中盤トレーニング戦略が強化学習のダイナミクスに与える影響を深く探究し、以下の知見を得ました。

まず、MegaMath-Web-Proのような高品質な数学コーパスは、基本モデルと強化学習の両方に同時に改善効果をもたらします。次に、質問と回答形式のデータ、特に長期間のCoT(Chain-of-Thought)推論を含むデータを使用することで、強化学習の効果をさらに高めることができます。第三に、長期間のCoTは強化学習トレーニング中に冗長性と不安定性をもたらします。最後に、中盤トレーニング段階で拡張を適用することで、下流の強化学習性能を向上させることができます。

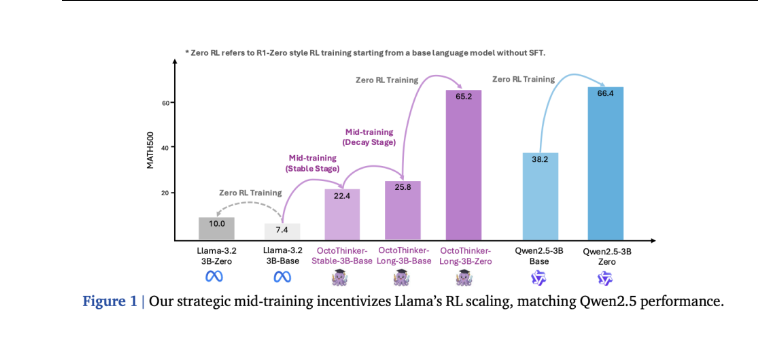

研究者たちは、「安定-減衰」と呼ばれる2段階の中盤トレーニング戦略を提案しました。まず、2,000億トークンで基本モデルをトレーニングし、その後、3つのCoT中心のサブタスクで200億トークンずつトレーニングを行います。最終的に、この戦略により、強化学習に優れたOctoThinkerモデルが生成されました。

RL設定とベンチマーク評価

研究者たちはMATH8Kデータセットを使って強化学習(RL)のトレーニングプロンプトを設定し、設定内容には全体のトレーニングバッチサイズ128、各クエリごとの16回のロールアウト応答、およびPPOの最小バッチサイズ64が含まれます。実験はLlama-3.2-3B-BaseとQwen2.5-3B-Baseモデルで行われました。評価では、基本言語モデルは少量のプロンプトを使用し、強化学習チューニングモデルはGSM8K、MATH500、OlympiadBench、AMC23などの指標タスクでゼロショットプロンプトを使用しました。

強化学習トレーニング中のQwenモデルの応答長は継続的に増加し、適切な範囲内で維持されていますが、Llamaモデルは異常な挙動を示し、平均応答長が4,096トークンに急上昇しています。評価結果によると、強化学習チューニング後のQwen2.5-3Bはすべてのベンチマークテストで改善が見られますが、Llama-3.2-3Bの改善はわずかです。

OctoThinkerはLlamaよりRL互換性が優れている

13の数学ベンチマークテストにおいて、各OctoThinkerのサブタスクは元のLlamaベースモデルよりも10%〜20%高い性能を示し、すべての規模の安定段階モデルで継続的な改善が確認されました。OctoThinker-Zeroシリーズは強化学習拡張プロセス中に多様な思考行動を示し、そのうちOctoThinker-Longバージョンが特に優れています。3B規模の基本モデルを比較した強化学習トレーニングでは、OctoThinker-Long-3Bは元のLlama-3.2-3Bモデルを上回り、強力な推論能力と広範な予訓練で知られるQwen2.5-3Bモデルと同等の性能を達成しました。混合サブタスクと短いサブタスクの性能はやや低く、特に挑戦的なベンチマークテストでは顕著です。

結論と今後の研究:RL対応型基本モデルへの道

この研究は、LlamaやQwenなどの基本モデルが強化学習推論プロセスにおいて異なる挙動を示す理由を深く探求し、中盤トレーニングが強化学習の拡張性において重要であることを強調しています。2段階の中盤トレーニング戦略により、Llamaは強化学習に適した基本モデルに変化し、最終的にOctoThinkerモデルが生まれました。

今後の研究方向には、中盤トレーニングを改善するためのより高品質な数学コーパスの構築;長期間のCoT推論モデルから抽出することなく、オープンなレシピを使ってRLに適した基本モデルを作成すること;QA形式とコンテンツを分離してそれぞれの寄与を別々に理解すること;そして新しいサブタスク(例:ツール統合推論)を通じてOctoThinkerファミリーを拡張することが含まれます。