Em 27 de março, às primeiras horas da manhã, a Alibaba lançou seu primeiro grande modelo multimodal completo: o Tongyi Qianwen Qwen2.5-Omni-7B. Este modelo possui recursos poderosos, capaz de processar simultaneamente vários tipos de entrada, incluindo texto, imagens, áudio e vídeo, e gerar texto e saída de voz natural em tempo real. Este avanço tecnológico inovador marca mais um progresso da Alibaba na área da inteligência artificial.

Em avaliações do OmniBench, um benchmark de fusão multimodal de autoridade, o Qwen2.5-Omni alcançou resultados notáveis, quebrando recordes do setor e superando modelos similares, como o Gemini-1.5-Pro do Google. Este resultado não apenas demonstra a poderosa capacidade do Qwen2.5-Omni, mas também consolida ainda mais a posição de liderança da Alibaba na competição tecnológica global.

Nota da fonte: A imagem foi gerada por IA, com autorização do provedor de serviços Midjourney.

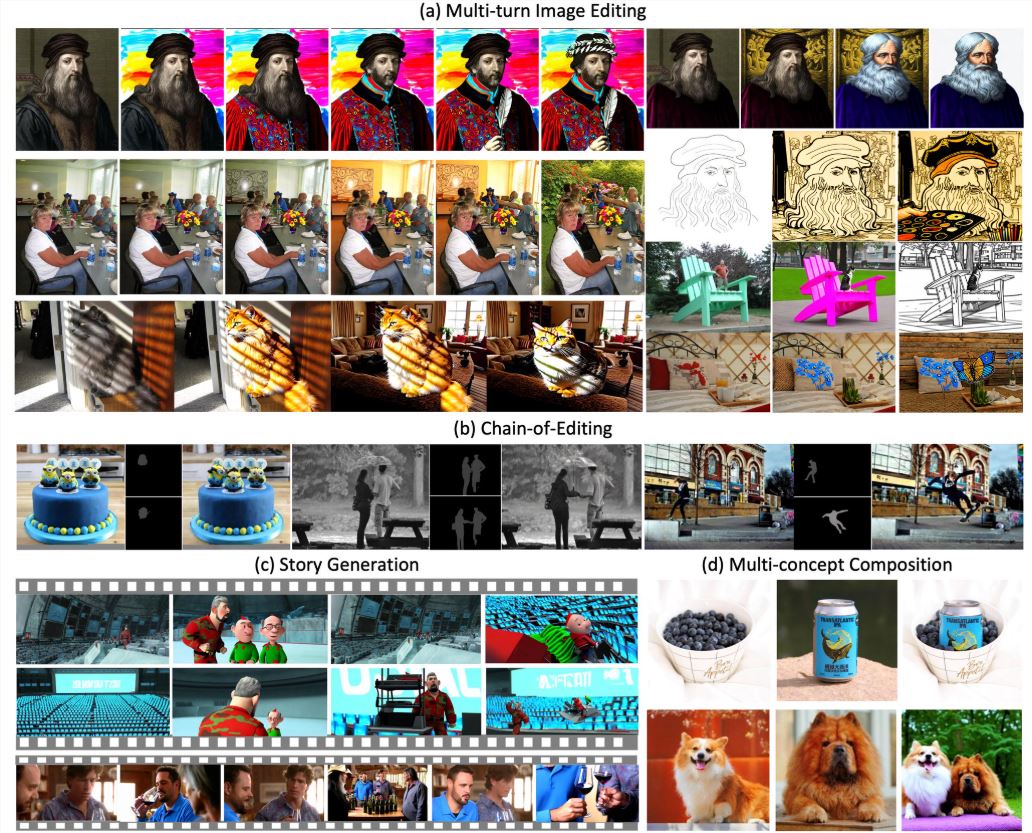

A singularidade do Qwen2.5-Omni reside em sua capacidade de simular os sentidos humanos, permitindo uma compreensão e cognição do mundo de forma "tridimensional", semelhante à humana. Isso significa que o Qwen2.5-Omni não apenas identifica várias entradas, mas também pode analisar o estado emocional através de áudio e vídeo, fornecendo feedback e capacidade de tomada de decisão mais inteligentes e naturais em tarefas complexas. Isso o torna mais flexível e adaptável em aplicações práticas.

Com o avanço contínuo da tecnologia de IA, o lançamento do Qwen2.5-Omni impulsionará, sem dúvida, o desenvolvimento do setor e fornecerá uma nova força motriz para a transformação digital em vários setores. Ao disponibilizar este grande modelo como código aberto, a Alibaba atraiu a atenção de desenvolvedores globais, criando condições para o desenvolvimento de mais aplicativos inovadores. No futuro, espera-se que o Qwen2.5-Omni tenha um impacto profundo em vários campos, como educação, saúde e entretenimento.

O lançamento da Alibaba representa não apenas um grande avanço tecnológico, mas também uma nova exploração de aplicações futuras de IA multimodal.